成功的大语言模型正在催生DPU发展机遇!

2023-04-19

18:56:48

来源: 杜芹

点击

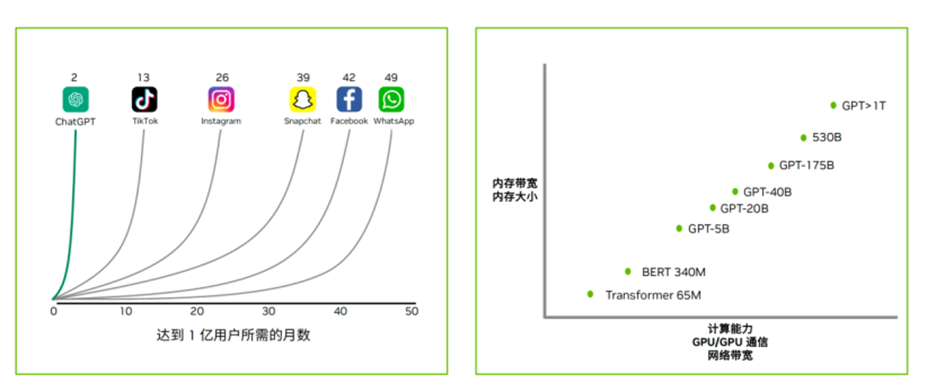

ChatGPT自去年11月30日发布,短短5天时间用户注册量就超过了100万,而仅仅两个月之后,就超过了1亿的注册用户,远超国际主流的应用如TikTok、ins等等,其火热程度可见一斑。成功的人工智能模型使人工智能训练和推理成为主流。

“在当下AI的竞赛中,有两个方式:一个是堆资源,就像造车一样,后造车永远比前造车的人要多烧更多的钱去打这个市场;另一个是在同样的资源情况下,要比竞争对手快,因此就需要提高效率,怎样提高效率,答案是DPU。在这个时间节点下,多数玩家拿着手里的牌在备货,很像是黎明前夜吹冲锋号之前在那囤积粮草,不会告诉你我有多少“弹药”,这里面主要包括训练和推理两方面。”英伟达网络市场总监孟庆在近日的一次媒体沟通会上谈到。

大语言模型正在引爆DPU发展机遇

对于ChatGPT这样的大模型,模型越大对AI回馈的效果越好。GPT从第一代大约50亿个参数,发展到GPT4.0大约将超过1T的参数,参数的规模呈现指数级别的增长。但这种增长模型的变化,也对内存带宽、内存大小、计算能力、GPU和CPU之间的通信、网络带宽等带来了诸多的挑战。不仅是大语言模型的公司在关注人工智能所带来的益处,每个企业都意识到人工智能可以增强其工作流程,但却面临着吞吐量和性能的瓶颈,硬件的成本投入也是一笔巨额的花费。

此外,这样大模型的训练对于电力的消耗也是巨大的:数据中心一年消耗的电力要大于2000亿度电,大约占用全球电力使用量的2%。2000亿度电什么概念?2021年整个三峡发了1036亿度电。而且随着人工智能的数据中心的部署,到2030年电力的使用预期的份额会达到5%。因此,提升数据中心的能效已经成为当下的燃眉之急。

为了充分发挥 AI 的潜力,并解决人工智能模型训练和推理带来的需求和挑战,英伟达祭出两大高性能网络平台,分别是Quantum-2 InfiniBand网络平台和Spectrum-4以太网网络平台,他们都是400G高带宽、高性能的网络架构,为全新应用提供加速的网络解决方案。而在这两大平台中核心组件就是被称为数据中心第三大算力支柱的DPU。

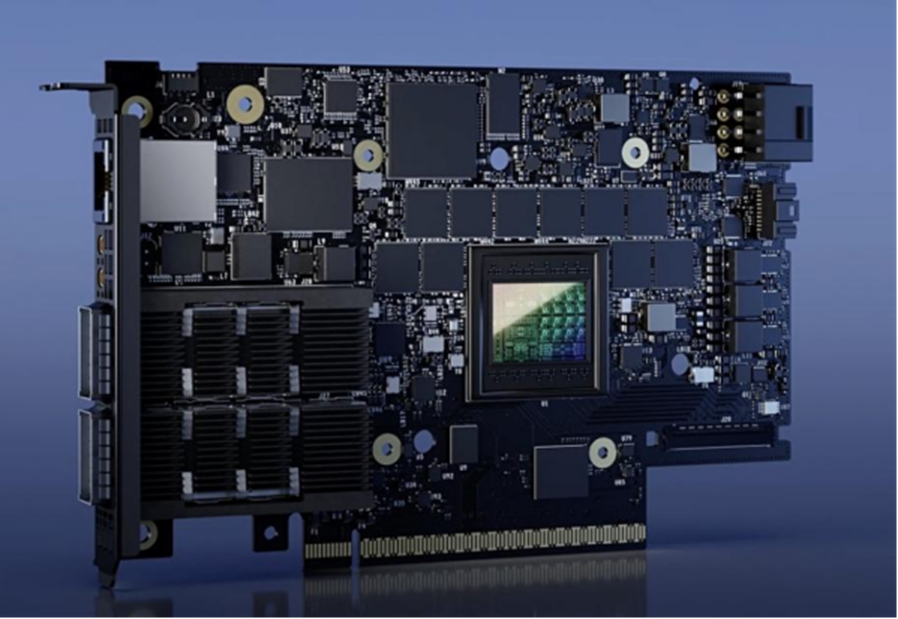

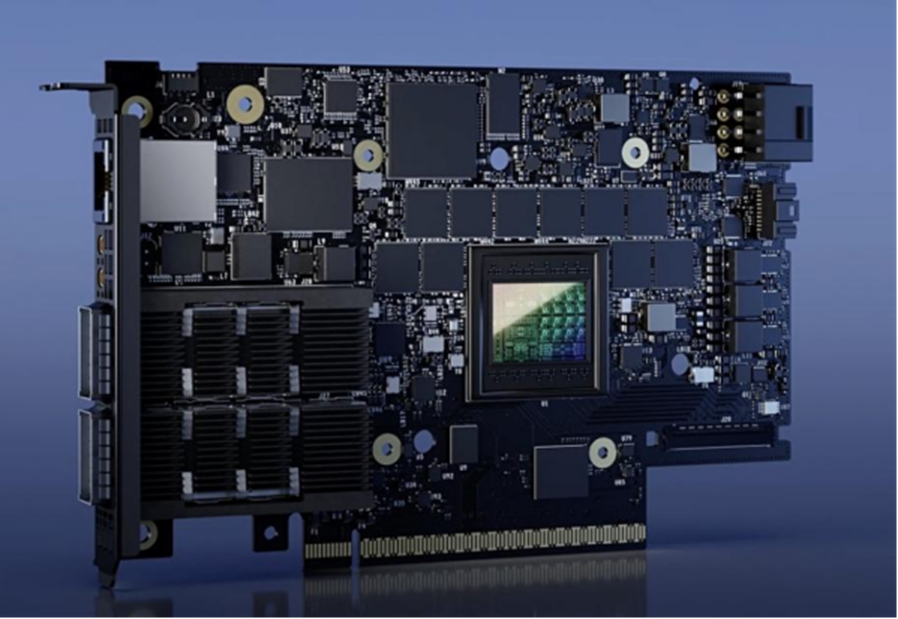

BlueField-3 DPU专为数据中心规模的计算而设计,提供400 Gb/s以太网和InfiniBand 网络连接,相比上一代可支持高达4倍的计算能力、高达4 倍的加密加速性能、2倍的存储处理性能和5倍的内存带宽。

NVIDIA BlueField-3 DPU卡

BlueField-3 DPU是一个软件定义、硬件加速的云服务计算平台。其优势主要体现在四大方面:1)加速性能,满足最严格的性能要求,运行最苛刻的工作负载;2)云规模效率,为业务应用程序释放 x86 内核,实现前所未有的规模和效率水平;3)强大的零信任安全,在不影响性能的情况下,确保全面的数据中心安全;4)完全可编程的基础设施,有DOCA一致的开发和运行应用程序,并保持最高性能DPU 加速服务器。

在今年的春季GTC大会上,英伟达宣布了BlueField-3 DPU全面量产的消息,预示着这是新的DPU的里程碑。据NVIDIA网络技术专家崔岩的介绍,“我们会从今年开始大规模的向市场去投放BlueField-3 DPU产品,我们合作伙伴也会在解决方案中集成NVIDIA BlueField-3 DPU。”

成功的大语言模型正在被各大公司参考。近日,微软在其博客中明确表示OpenAI采用的硬件是基于英伟达智能网卡和InfiniBand网络来构建网络架构,这一样本已经被很多公司参考,而在另一个博客里微软负责AI的架构师也表示了对DPU的赞许。百度智能云也小规模测试了英伟达DPU和GPU的配合,与传统方式和其他竞品相比,获得了惊讶的数据。“为什么现在大家愿意把DPU跟GPU按照大模型成功模式去参考?就是因为我们自己的DPU跟自己做的GPU会有更好性能上的匹配,能够相互做得更好进行技术支撑。如果说换成别的DPU可能就不具备跟GPU之间这么紧密的关系,可能就需要在上面再重新搭建相应的技术模块才可以。”崔岩指出。

BlueField-3 DPU加速的实际表现如何?

那么,利用BlueField-3 DPU的实际应用情况究竟如何?在会上,崔岩列举了四个BlueField-3 DPU的用例。

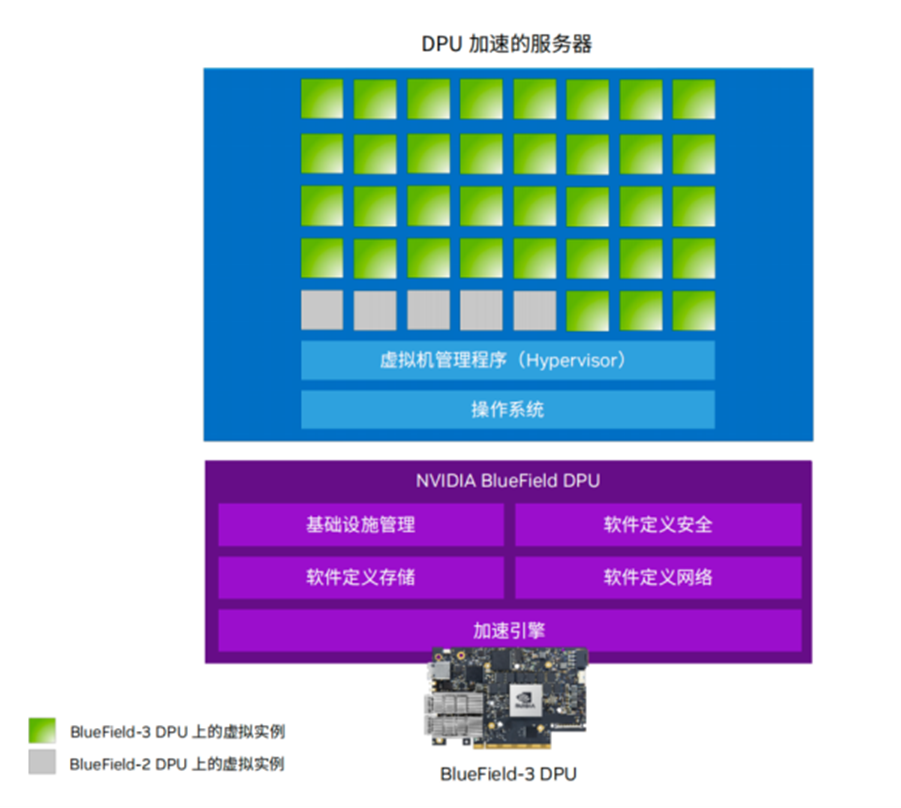

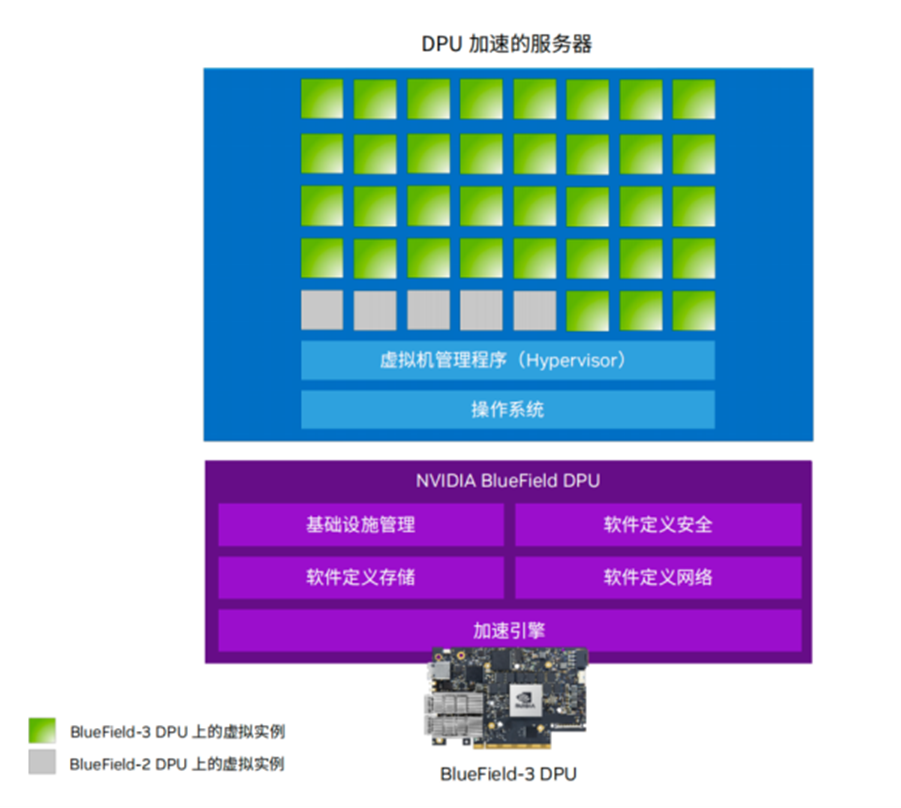

用例一:加速云计算。BlueField-3 DPU最多可支持4096个虚拟机,是之前BlueField-2 DPU的大概四倍到八倍。在服务器硬件并不大幅改变的情况下,仅在网络部分进行升级,就可以实现支撑8倍虚拟机的情况。这样可以更多的去承载业务应用。对于云计算服务商而言,可以获得更高的投资回报率和更低的总体拥有成本。

用例二:安全云计算。BlueField-3 DPU可在多租户的环境里去提供数据中心的控制平面,去做租户之间的隔离,还有业务应用域和基础设施域之间的隔离,也提供了零信任安全部署的平台,可以在数据移动过程和存储存取过程当中,保证整个数据中心的安全性。

用例三:加速企业计算。除了云计算平台之外,BlueField-3 DPU也在跟VMware合作。下图是利用BlueField-3 DPU加速VMware vSphere虚拟化堆栈的实例,左边的图以Redis事务处理为例,如果采用BlueField-3 DPU可以增50% Redis事务处理能力,但是它对主机CPU核心占用就可以归零,所有的基础设施相关的业务全部都会跑到DPU上。CPU被释放出来之后,CPU就可以拿去做更多的业务应用。

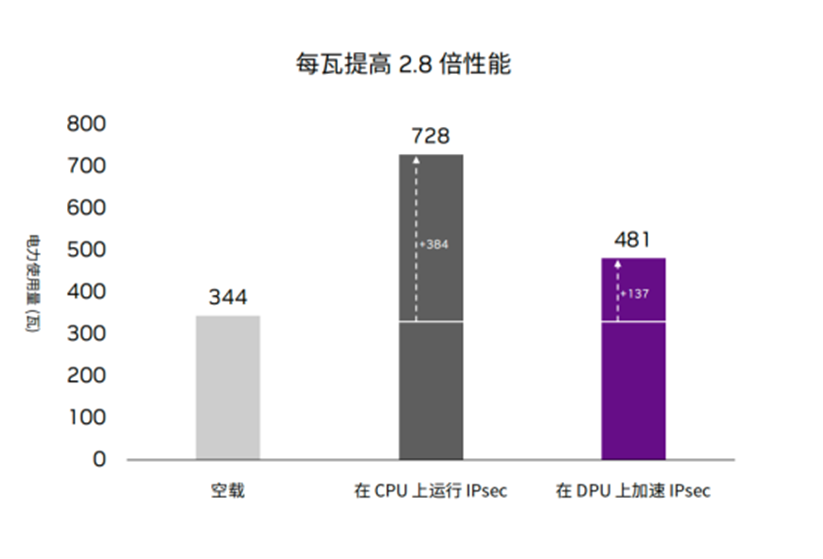

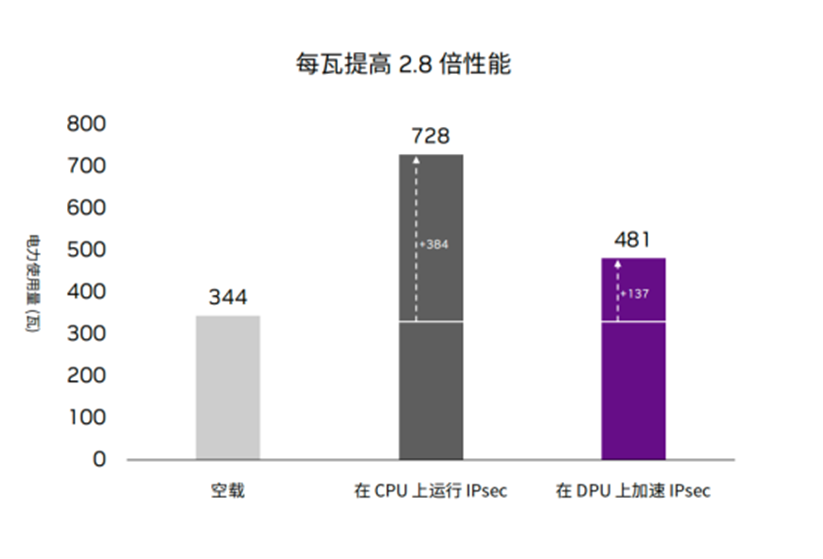

用例四:可持续云计算。简单来说,BlueField-3 DPU应用将提升服务器主机的性能,把所有基础设施工作负载卸载到BlueField-3 DPU上,释放出来的CPU算力资源就可以拿来去做业务应用,这样的话就相当于你的服务器在没增加的情况下可以做更多的业务,或者你做一个业务的时候所需的服务器的数量就可以减少。从下边的耗电量图来看,服务器在空载状态下的耗电是334瓦,如果把IPsec功能运行上去,耗电将大幅度提高变到728瓦。而如果把IPsec功能卸载到DPU,不用CPU来做,它只需要481瓦。除了释放CPU核心以外,它还可以节省整个服务器电能的消耗。

NVIDIA DOCA为DPU注入灵魂

“没有软件的芯片就是一堆昂贵的沙子(和硅晶圆同出一辙)。”英伟达网络市场总监孟庆如是说。要想充分发挥BlueField DPU这颗强大的片上数据中心基础设施的硬件能力,离不开其DOCA软件这个推手。NVIDIA DOCA 是专为 BlueField DPU 设计的 SDK 和加速框架。DOCA 旨在通过为 BlueField DPU 快速创建和部署应用程序和服务来开启数据中心创新。

最近几年来,NVIDIA DOCA的版本更新速度非常快。DOCA 2.0是最新版本,伴随BlueField-3 DPU正式发布。它增加了对 BlueField-3 数据路径加速器 (DPA) 编程子系统的支持,以及多项安全增强功能,包括DOCA IPsec加密/解密库、设备认证和YARA规则,还包括对DOCA Flow库的增强。 DOCA向下兼容以前的版本,比如最新发布的DOCA 2.0也能运行在上一代BlueField-2 DPU上,只是有些功能没有办法完全实现。

BlueField-3 DPU有三套编程环境:分别是ARM、加速的可编程管道线(Pipeline)和数据据路径加速器“新增的第三个环境就是数据路径的加速器(DPA),这是一套RISC-V架构的编程环境,它是利用RISC-V内核的处理器。DPA专为网络密集型、低计算任务而构建,例如设备仿真、拥塞控制、自定义协议等。所以我们一个DPU里提供三个不同异构的代码环境,每个架构有它自己的优势,我们用DOCA的软件框架把它统一起来,开发者完全不用在意底层架构。”孟庆介绍到。

现在社区里已经有多个不同的DOCA API文档去教你怎么部署、怎么使用、怎么编程,全球的开发者也已经超过4700多个。

尤为值得一提的是,DOCA的中国开发者社区发展迅速。2021年末时中国社区占了全球开发者42%,到2023年1月,中国社区的开发者达到了56%。英伟达也在积极开展黑客松竞赛活动,目前已经举办了两届。

写在最后

如今,随着技术的不断发展,CPU的性能提升越来越难以实现大幅度的进展。每年发布的新一代CPU,其性能提升不到上一代的10%。而与之相比,GPU则能够实现4-5倍甚至十倍以上的性能提升。在这样的情况下,CPU的提升速度变慢会限制整个系统的效率,因此需要通过利用DPU来释放CPU算力。尤其是随着像大型语言模型等需求的增加,利用DPU来提高效率将成为未来的发展方向。因此,开发更加高效的DPU技术将有助于实现更高的计算效率和更好的性能表现。

“在当下AI的竞赛中,有两个方式:一个是堆资源,就像造车一样,后造车永远比前造车的人要多烧更多的钱去打这个市场;另一个是在同样的资源情况下,要比竞争对手快,因此就需要提高效率,怎样提高效率,答案是DPU。在这个时间节点下,多数玩家拿着手里的牌在备货,很像是黎明前夜吹冲锋号之前在那囤积粮草,不会告诉你我有多少“弹药”,这里面主要包括训练和推理两方面。”英伟达网络市场总监孟庆在近日的一次媒体沟通会上谈到。

大语言模型正在引爆DPU发展机遇

对于ChatGPT这样的大模型,模型越大对AI回馈的效果越好。GPT从第一代大约50亿个参数,发展到GPT4.0大约将超过1T的参数,参数的规模呈现指数级别的增长。但这种增长模型的变化,也对内存带宽、内存大小、计算能力、GPU和CPU之间的通信、网络带宽等带来了诸多的挑战。不仅是大语言模型的公司在关注人工智能所带来的益处,每个企业都意识到人工智能可以增强其工作流程,但却面临着吞吐量和性能的瓶颈,硬件的成本投入也是一笔巨额的花费。

此外,这样大模型的训练对于电力的消耗也是巨大的:数据中心一年消耗的电力要大于2000亿度电,大约占用全球电力使用量的2%。2000亿度电什么概念?2021年整个三峡发了1036亿度电。而且随着人工智能的数据中心的部署,到2030年电力的使用预期的份额会达到5%。因此,提升数据中心的能效已经成为当下的燃眉之急。

为了充分发挥 AI 的潜力,并解决人工智能模型训练和推理带来的需求和挑战,英伟达祭出两大高性能网络平台,分别是Quantum-2 InfiniBand网络平台和Spectrum-4以太网网络平台,他们都是400G高带宽、高性能的网络架构,为全新应用提供加速的网络解决方案。而在这两大平台中核心组件就是被称为数据中心第三大算力支柱的DPU。

BlueField-3 DPU专为数据中心规模的计算而设计,提供400 Gb/s以太网和InfiniBand 网络连接,相比上一代可支持高达4倍的计算能力、高达4 倍的加密加速性能、2倍的存储处理性能和5倍的内存带宽。

NVIDIA BlueField-3 DPU卡

BlueField-3 DPU是一个软件定义、硬件加速的云服务计算平台。其优势主要体现在四大方面:1)加速性能,满足最严格的性能要求,运行最苛刻的工作负载;2)云规模效率,为业务应用程序释放 x86 内核,实现前所未有的规模和效率水平;3)强大的零信任安全,在不影响性能的情况下,确保全面的数据中心安全;4)完全可编程的基础设施,有DOCA一致的开发和运行应用程序,并保持最高性能DPU 加速服务器。

在今年的春季GTC大会上,英伟达宣布了BlueField-3 DPU全面量产的消息,预示着这是新的DPU的里程碑。据NVIDIA网络技术专家崔岩的介绍,“我们会从今年开始大规模的向市场去投放BlueField-3 DPU产品,我们合作伙伴也会在解决方案中集成NVIDIA BlueField-3 DPU。”

成功的大语言模型正在被各大公司参考。近日,微软在其博客中明确表示OpenAI采用的硬件是基于英伟达智能网卡和InfiniBand网络来构建网络架构,这一样本已经被很多公司参考,而在另一个博客里微软负责AI的架构师也表示了对DPU的赞许。百度智能云也小规模测试了英伟达DPU和GPU的配合,与传统方式和其他竞品相比,获得了惊讶的数据。“为什么现在大家愿意把DPU跟GPU按照大模型成功模式去参考?就是因为我们自己的DPU跟自己做的GPU会有更好性能上的匹配,能够相互做得更好进行技术支撑。如果说换成别的DPU可能就不具备跟GPU之间这么紧密的关系,可能就需要在上面再重新搭建相应的技术模块才可以。”崔岩指出。

BlueField-3 DPU加速的实际表现如何?

那么,利用BlueField-3 DPU的实际应用情况究竟如何?在会上,崔岩列举了四个BlueField-3 DPU的用例。

用例一:加速云计算。BlueField-3 DPU最多可支持4096个虚拟机,是之前BlueField-2 DPU的大概四倍到八倍。在服务器硬件并不大幅改变的情况下,仅在网络部分进行升级,就可以实现支撑8倍虚拟机的情况。这样可以更多的去承载业务应用。对于云计算服务商而言,可以获得更高的投资回报率和更低的总体拥有成本。

用例二:安全云计算。BlueField-3 DPU可在多租户的环境里去提供数据中心的控制平面,去做租户之间的隔离,还有业务应用域和基础设施域之间的隔离,也提供了零信任安全部署的平台,可以在数据移动过程和存储存取过程当中,保证整个数据中心的安全性。

用例三:加速企业计算。除了云计算平台之外,BlueField-3 DPU也在跟VMware合作。下图是利用BlueField-3 DPU加速VMware vSphere虚拟化堆栈的实例,左边的图以Redis事务处理为例,如果采用BlueField-3 DPU可以增50% Redis事务处理能力,但是它对主机CPU核心占用就可以归零,所有的基础设施相关的业务全部都会跑到DPU上。CPU被释放出来之后,CPU就可以拿去做更多的业务应用。

用例四:可持续云计算。简单来说,BlueField-3 DPU应用将提升服务器主机的性能,把所有基础设施工作负载卸载到BlueField-3 DPU上,释放出来的CPU算力资源就可以拿来去做业务应用,这样的话就相当于你的服务器在没增加的情况下可以做更多的业务,或者你做一个业务的时候所需的服务器的数量就可以减少。从下边的耗电量图来看,服务器在空载状态下的耗电是334瓦,如果把IPsec功能运行上去,耗电将大幅度提高变到728瓦。而如果把IPsec功能卸载到DPU,不用CPU来做,它只需要481瓦。除了释放CPU核心以外,它还可以节省整个服务器电能的消耗。

NVIDIA DOCA为DPU注入灵魂

“没有软件的芯片就是一堆昂贵的沙子(和硅晶圆同出一辙)。”英伟达网络市场总监孟庆如是说。要想充分发挥BlueField DPU这颗强大的片上数据中心基础设施的硬件能力,离不开其DOCA软件这个推手。NVIDIA DOCA 是专为 BlueField DPU 设计的 SDK 和加速框架。DOCA 旨在通过为 BlueField DPU 快速创建和部署应用程序和服务来开启数据中心创新。

最近几年来,NVIDIA DOCA的版本更新速度非常快。DOCA 2.0是最新版本,伴随BlueField-3 DPU正式发布。它增加了对 BlueField-3 数据路径加速器 (DPA) 编程子系统的支持,以及多项安全增强功能,包括DOCA IPsec加密/解密库、设备认证和YARA规则,还包括对DOCA Flow库的增强。 DOCA向下兼容以前的版本,比如最新发布的DOCA 2.0也能运行在上一代BlueField-2 DPU上,只是有些功能没有办法完全实现。

BlueField-3 DPU有三套编程环境:分别是ARM、加速的可编程管道线(Pipeline)和数据据路径加速器“新增的第三个环境就是数据路径的加速器(DPA),这是一套RISC-V架构的编程环境,它是利用RISC-V内核的处理器。DPA专为网络密集型、低计算任务而构建,例如设备仿真、拥塞控制、自定义协议等。所以我们一个DPU里提供三个不同异构的代码环境,每个架构有它自己的优势,我们用DOCA的软件框架把它统一起来,开发者完全不用在意底层架构。”孟庆介绍到。

现在社区里已经有多个不同的DOCA API文档去教你怎么部署、怎么使用、怎么编程,全球的开发者也已经超过4700多个。

尤为值得一提的是,DOCA的中国开发者社区发展迅速。2021年末时中国社区占了全球开发者42%,到2023年1月,中国社区的开发者达到了56%。英伟达也在积极开展黑客松竞赛活动,目前已经举办了两届。

写在最后

如今,随着技术的不断发展,CPU的性能提升越来越难以实现大幅度的进展。每年发布的新一代CPU,其性能提升不到上一代的10%。而与之相比,GPU则能够实现4-5倍甚至十倍以上的性能提升。在这样的情况下,CPU的提升速度变慢会限制整个系统的效率,因此需要通过利用DPU来释放CPU算力。尤其是随着像大型语言模型等需求的增加,利用DPU来提高效率将成为未来的发展方向。因此,开发更加高效的DPU技术将有助于实现更高的计算效率和更好的性能表现。

责任编辑:sophie

-

- 半导体行业观察

-

- 摩尔芯闻