英伟达布局人工智能的下一个未来

2021-02-28

14:00:19

来源: 半导体行业观察

得益于公司成立以来对GPU的专注和对CUDA生态十年如一日的坚持,英伟达公司终于在最近几年走上了巅峰,这主要得益于AI时代的大爆发。尤其是在人工智能的训练市场,英伟达的GPU迄今为止也没有遇到能威胁到他们的挑战者。但他们并不止步于此,在收购了Mellanox之后,英伟达又将目光投向了Arm,希望借此拓宽公司的目标市场。

与此同时,英伟达在内部还投入到软件方面的布局,如迁移学习,就是他们近年来非常关注的一个着力点。按照英伟达方面所说,这项技术正是他们针对当前人工智能“痛点”所做出的一种解决方案。

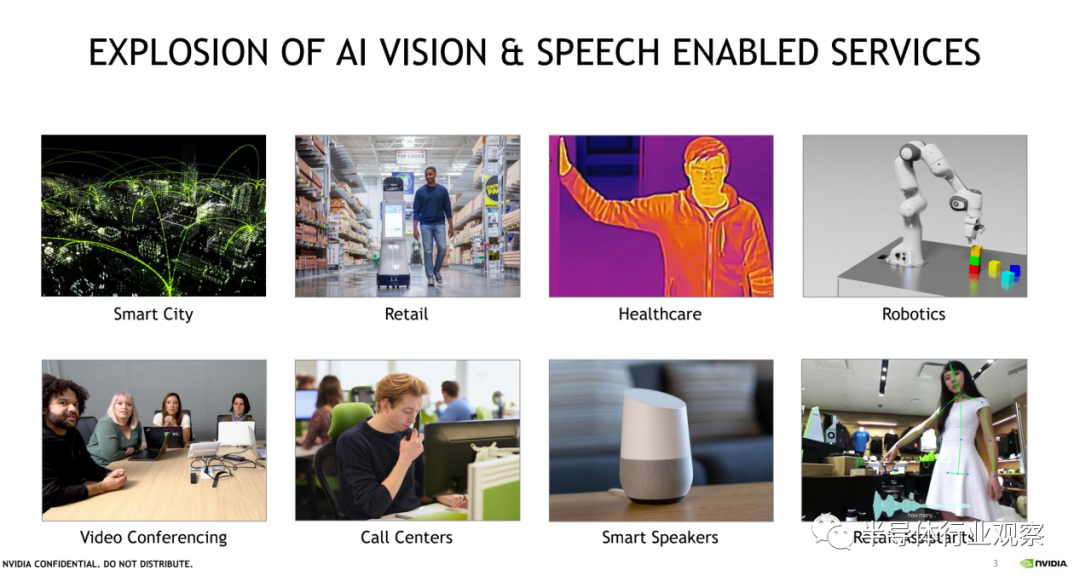

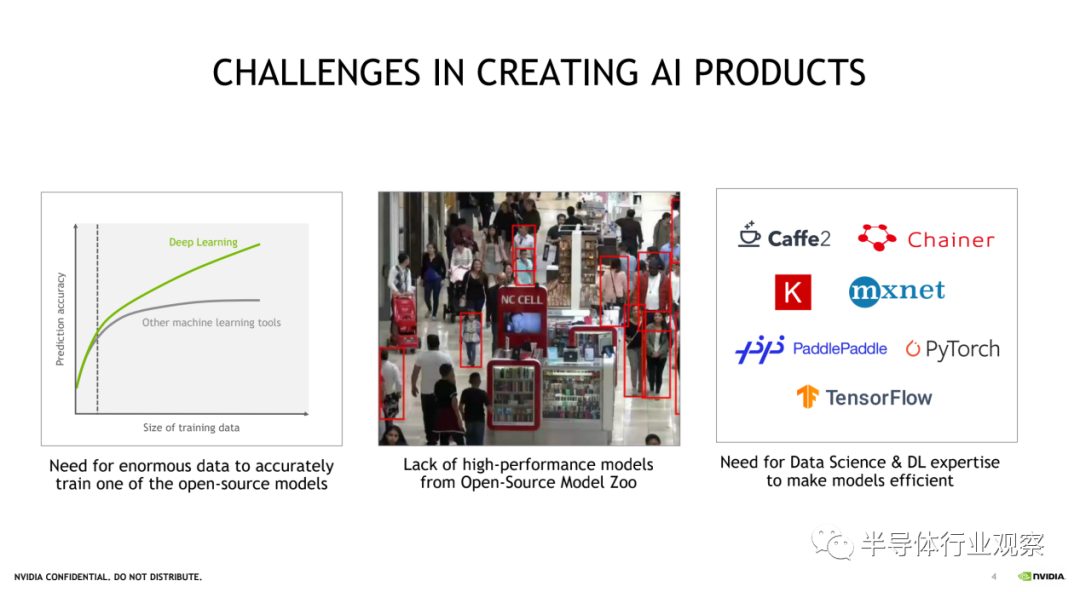

从相关报道我们可以看到,人工智能已经走向了各行各业。同时我们也认识到,从头开发一个AI应用,需要经历训练得出模型和推理的过程。但因为现在的应用繁多,如果所有的开发者和初创公司都需要从头开始创建一个模型,这不仅会耗时耗力,同时还成本高昂。这就让“迁移学习”找到了机会。

所谓迁移学习,是指将已经在相关任务中训练过的模型的一部分复用到新模型中,从而很大程度地降低对大量计算资源的需要。具体而言就是可以从现有神经网络中提取已学习特征,并通过从现有神经网络转移权重来迁移这些已学习特征,而英伟达的Transfer Learning Toolkit(迁移学习工具包,简称TLT)就是当中的一个代表。

据介绍,英伟达迁移式学习工具包(是一个基于Python的工具包,它提供了大量预先训练的模型,并提供一系列的工具,使流行的网络架构适应开发者自己的数据,并且能够训练、调整、修剪和导出模型,以进行部署。

在2018年发布第一代工具包的时候,英伟达方面也表示,这套方案拥有许多预训练的优化过的领域特定DNN,预先打包在里面;有计算机视觉中,物体分类、检测的应用示例;在异构的多GPU环境中,易于做模型适应 (Model Adaptation) ,易于重新训练;可以轻松修改配置文件,增加新类别、新特征,压缩模型大小;Model Export API可以把模型轻松部署在英伟达的DeepStream SDK 3.0上,做智能视频分析 (IVA) 应用;Model Export API在可以把模型部署到Clara平台上,来做医学影像相关应用。

自第一代产品发布以来,英伟达TLT收到了开发者的热烈欢迎。公司也持之以恒地投入,并于近日推出了多个可直接用于生产的预训练模型和迁移学习工具包(Transfer Learning Toolkit, TLT)3.0 开发者测试版,以及 DeepStream SDK 5.1。据介绍,此次发布包括一系列新型预训练模型。这些模型具有支持对话式 AI 应用的创新功能,可提供更加强大的解决方案来加速开发者从训练到部署的整个过程。

英伟达方面表示,预训练模型和 TLT 3.0(开发者测试版)包括以下主要亮点:

1、全新视觉 AI 预训练模型:车牌检测与识别、心率监测、手势识别、视线估计、情绪识别、人脸检测、面部特征点估计;

2、通过自动语音识别(ASR)和自然语言处理(NLP)的预训练模型支持对话式 AI 用例

3、选择流行的网络架构进行训练,如 EfficientNet、YoloV4 和 UNET;

4;经过改进的 PeopleNet 模型可以检测困难场景,比如坐着的人和旋转/扭曲的物体

6;支持具有第三代张量核心的 NVIDIA Ampere GPU,从而提升性能

“借助 TLT,您可以通过 NVIDIA 为常见 AI 任务开发的多用途生产级模型或者 ResNet、VGG、FasterRCNN、RetinaNet 和 YOLOv3/v4 等 100 多种神经网络架构组合,使用自己的数据对特定用例的模型进行微调。所有模型均可从 NGC 获得。”英伟达方面强调。

人工智能行业专家吴恩达教授在NIPS 2016 讲座上表示:“在监督学习之后,迁移学习将引领下一波机器学习技术商业化浪潮。”由此可以看到,英伟达又一次走上了AI的风口。

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第2600内容,欢迎关注。

『

半导体第一垂直媒体

』

实时 专业 原创 深度

识别二维码

,回复下方关键词,阅读更多

晶圆|MCU

|射频|封测|美国|苹果|华为|汽车芯片

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复

搜索

,还能轻松找到其他你感兴趣的文章!

责任编辑:Sophie