来源:内容由半导体行业观察(ID:icbank)编译自「

Venturebeat

」,谢谢。

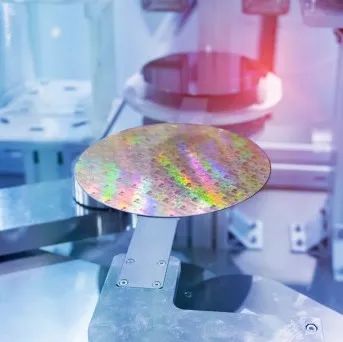

IBM苏黎世实验室的研究人员本周在Nature Communications上发表了一篇论文。在文中他们声称,基于相变存储器的技术,他们已经开发出了一种能同时能高实现能源效率和高精度的机器学习方案。这是一种使用基于电阻的存储设备来实现内存内计算的方法,它们的方法弥补了存储和计算数据分开的方案的缺陷,并在此过程中大大降低了功耗。

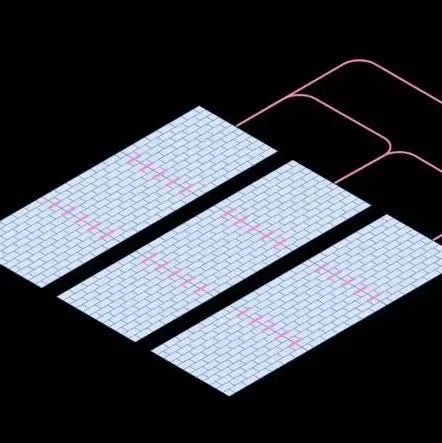

文章表示,许多现有的AI推理方案在物理上拆分了内存和处理单元,导致AI模型存储在片外内存中。这会增加计算开销,因为必须在各个单元之间对数据进行转移,这会减慢处理速度并增加用电量。

IBM的技术表面上解决了相变存储器的问题,相变存储器是一种非易失性存储器,比常用的闪存技术要快。这项工作如果被证明具有可扩展性,则可以为在无人机,机器人,移动设备和其他受计算限制的设备中运行AI的强大硬件铺平道路。

正如IBM团队所解释的那样,相变存储设备面临的挑战是它趋向于引入计算误差(computational inaccuracy)。那是因为它本质上是模拟的。由于可变性以及读写电导噪声,其精度受到限制。

研究提出的解决方案需要在软件中的AI模型训练期间注入额外的噪声,以提高模型的弹性。结果表明它是成功的。在将训练后的权重(即,用于转换输入数据的参数)映射到相变存储器组件后,加入额外噪音在流行的CIFAR-19 数据集可以把训练ResNet模型精度提升到93.7%,而ImageNet的精度可以做到71.6%.

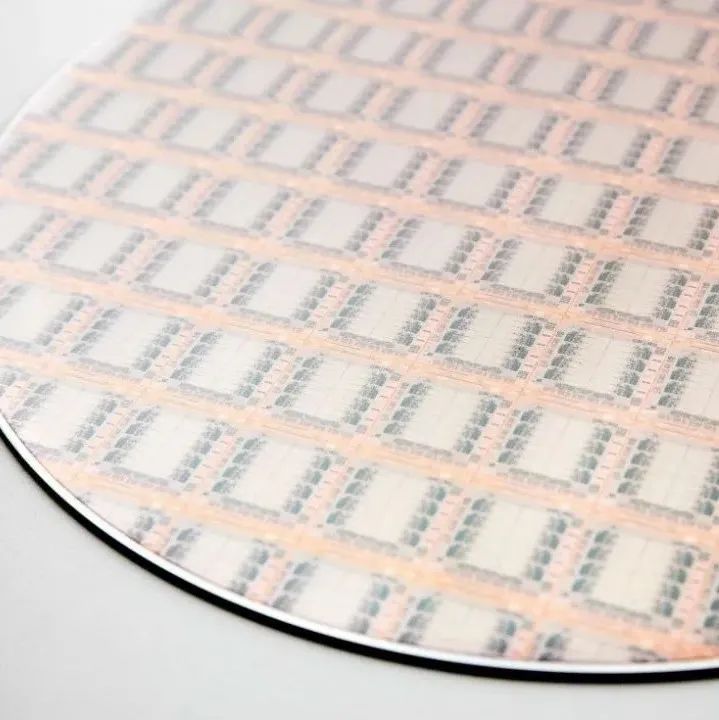

此外,在将特定模型的权重映射到原型芯片中的723,444个相变存储设备上之后,在单天的过测试程中,精度保持在92.6%以上。研究人员声称这是一个记录。

为了进一步提高精度随时间的保持性,该研究的合著者还开发了一种补偿技术,该技术可以在推理过程中定期校正激活函数(确定模型输出的方程式)。他们说,这导致硬件精度提高到93.5%。

同时,该团队使用模拟相变存储组件对训练机器学习模型进行了实验。报告称,他们使用混合精度架构在几种类型的小规模模型上实现了“软件等效”的准确性,这些模型包括多层感知器,卷积神经网络,长期短期记忆网络和生成对抗网络。他们最近在《神经科学前沿》上发表的一项研究中详细介绍了训练实验。

IBM在该领域的最新工作是在引入用于AI训练的相变存储芯片之后。但据报道,公司的这项技术仍处于研究阶段的同时,公司研究人员证明了该系统可以将权重数据存储为电荷,每平方毫米的计算量是图形卡的100倍,而功耗却要低280倍。

IBM表示:“在一个越来越多应用(包括物联网电池供电的设备和自动驾驶汽车)向AI迈进的时代,快速,低功率且可靠的DNN推理引擎是非常有吸引力.

在一份声明中他们表示。我们正在研究中的AI硬件加速器架构在支持DNN训练和推理方面巨大潜力。”

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第2314期内容,欢迎关注。

『

半导体第一垂直媒体

』

实时 专业 原创 深度

识别二维码

,回复下方关键词,阅读更多

美国|台积电|

RISC-V

|汽车芯片

|

AI

|CMOS

|中芯国际|苹果|射频|

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复

搜索

,还能轻松找到其他你感兴趣的文章!