[原创] Nvidia发布史上最快GPU,黄仁勋在线带货

2020-05-15

14:14:51

来源: Sophie

北京时间2020年5月14日,NVIDIA创始人兼首席执行官黄仁勋在加利福尼亚的家中,为NVIDIA GTC 2020揭开了该公司的首个“厨房主题演讲”。这次大会NVDIA首款Ampere架构的GPU终于面世,黄仁勋更是为史上最大的DGX A100在线带货,让我们一起看看黄教主的带货技巧。

Nvidia首款Ampere GPU,史上最大的7nm芯片

Nvidia昨晚发布了其下一代Ampere GPU架构-NVDIA A100。正值大流行和对云计算需求的巨大增长之际,英伟达推出的A100正是主要用于数据中心。A100每个芯片都装有540亿个晶体管,使其成为台积电制造的世界上最大的7纳米芯片。它使用台积电CoWoS的3D封装技术,专为科学计算,云图形和数据分析而构建。

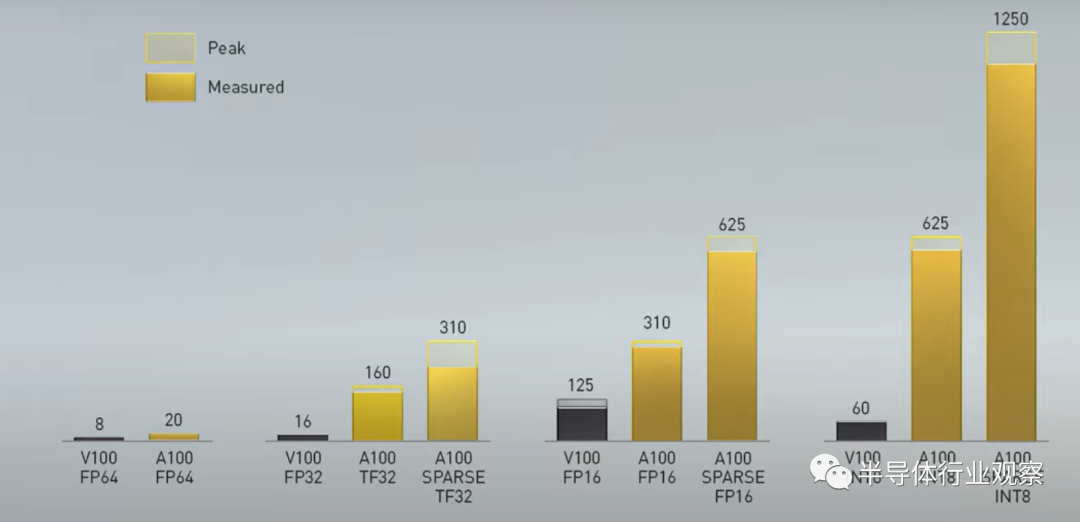

Ampere GPU采用了新的Tensor Core AI核心,支持TF32运算,无需任何代码改变就可以让AI性能提升20倍,还支持FP64双精度运算,与HPC应用相比带来了2.5倍的性能。在训练AI模型时使用32位FP传输高达312 TFLOPS,在INT8上可运行1,248 TOPS以进行推理。

黄仁勋说:“ NVIDIA A100 GPU是AI性能的20倍飞跃,是从数据分析到训练再到推理的端到端机器学习加速器。” “这是第一次,可以在一个平台上加速横向扩展和横向扩展工作负载。NVIDIA A100将同时提高吞吐量并降低数据中心的成本。”

这还不够,Ampere拥有一个称为MIG的新架构,它可以将一个GPU划分为七个独立的GPU,每个GPU都可以执行各种大小的不同计算任务,以优化使用率。

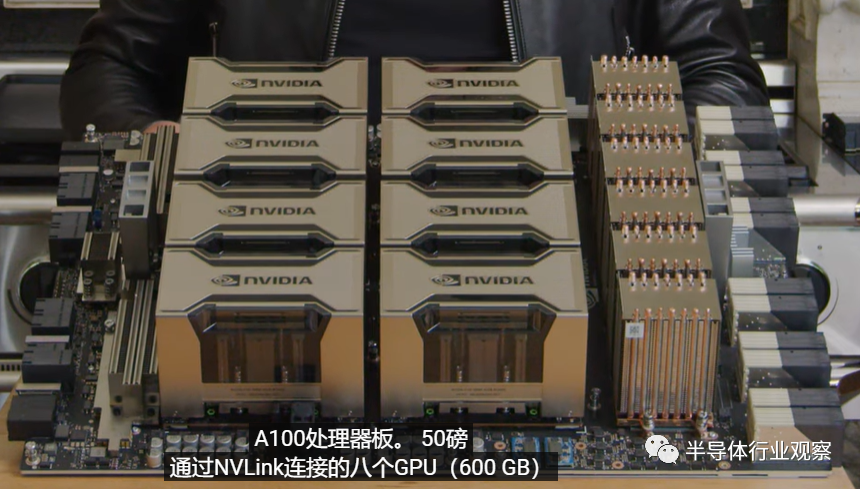

那么当八台A100放在一起时会发生什么?你将获得一个DGX A100系统,以在特别大的数据集或超级计算集群上训练模型。

DGX A100重50镑,通过NVLink连接8个600G的GPU,它经过一百万次钻孔,一公里的走线连接,总共有30000个组件组成。在DGX中,它每分钟移动700立方英尺。

DGX A100是一个出色的机器,A100保证了5 petaflops的性能,并且将它们与Nvidia的第三代NVLink版本结合使用。将这八个GPU结合在一起,就意味着拥有320GB的GPU内存和12.4TB / s的内存带宽。它还采用了Nvidia Mellanox ConnectX-6 HDR,因此该系统可以以每秒3.6 TB的速度连接到其他网络接口。随着现代数据中心适应日益多样化的工作负载,Mellanox的技术将对Nvidia变得越来越重要。

黄仁勋狠狠的夸赞了Ampere架构的优势,称它不仅训练的快,还有着令人难以置信的推理能力,也有能力将自身分解为更多的GPU来进行扩展,无论是推理还是云计算,都有着灵活、加速和高利用率的数据中心架构。

而且其与当今最流行的BERT 训练模型相比,在经过3年的优化训练之后,基于Ampere的A100的性能是BERT模型的6倍!但晶体管预算仅增加了约70%。现在,Ampere是世界上最大最复杂的处理器。在数千名工程师的努力下,将Ampere集中在这一个不可思议的芯片中。DGX是NVDIA的第三代系统,它是世界上第一个完全集成的AI系统。A100可以开箱即用,且训练性能比Volta V100提高6倍。推理性能是Volta V100的7倍,T4的12倍!

所以,你既可以用DGX A100来训练,也可以进行推理,你甚至可以将其与56个不同的用户共享,他们每个人都有等效的性能。

好了,重点来了,那么它到底值多少钱呢?如果将其与价值10000美元最高端的服务器相比较,DGX A100是其价格的150倍。所有以上这些好的性能加一起,只要199,000美元!黄教主在线带货!连用两个Incredible,Incredible的性能,Incredible的价值,买它!

为什么一定要买它呢?假如你不买A100,而是选用NVIDIA的HGX A100主板来建立超大规模数据中心的话,它将会是下面这个样子:

上图是今天典型的AI数据中心,它里面有很多DGX,与Voltas并行运行来进行训练等等,这个数据中心中有50个DGX和600个CPU系统用于AI推理和数据处理。它要花费价值1100万美元,消耗630KW,这是什么概念呢?黄仁勋轻描淡写到,大约是一个州的价格!

但是有了A100,就是下面这个难以置信的样子。这就是新架构的好处,高吞吐量与MIG实例以及数据处理能力的高度结合,将深度学习和推理等全部集中在一个计算平台上。这样一来,只需花费100万美元,而且功耗28KW,仅是成本和功耗的十分之一。

Nvidia的DGX A100系统已经开始发售,其中一些最初的应用包括在美国阿贡国家实验室进行的对COVID-19的研究。

英伟达表示,微软,亚马逊,谷歌,戴尔,阿里巴巴和许多其他大型云服务提供商也计划将单个A100 GPU整合到自己的产品中。黄仁勋说:“全世界所有超大规模生产者和计算机制造商对Ampere的采用和热情都是前所未有的。” “这是我们有史以来最快的新数据中心架构发布,这是可以理解的。”

Nvidia从非常大的DGX SuperPOD跃升到了小型EGX A100,用于处理从物联网设备(无论是照相机还是智能冰箱)中的传感器输入的数据。

EGX A100每秒最多可以接收200GB的数据。新架构还允许在将芯片处理的来自IoT传感器的数据直接发送到GPU之前进行加密,从而使其更安全地应用于医疗保健或零售业。

黄仁勋表示:“物联网和AI的融合引发了“智慧一切”的革命。大型行业现在可以提供智能连接产品和服务,就像电话行业使用智能手机一样。NVIDIA的EGX Edge AI平台将标准服务器转变为微型,云原生,安全的AI数据中心。借助我们的AI应用程序框架,公司可以构建从智能零售到机器人工厂再到自动呼叫中心的AI服务。”

此外,还发布了EGX Jetson Xavier NX,EGX Jetson Xavier NX是全球体积最小、性能最强大的AI超级计算机,适用于微型服务器和边缘智能物联网盒。Jetson Xavier NX模块是加速AI应用的理想平台,与被业界广泛采用的前代产品Jetson TX2相比,其性能提高了10倍以上。通过运用云原生技术,开发人员即可利用这块仅有信用卡尺寸大小的高AI功能与高计算性能的模块。运行EGX云原生软件堆栈的EGX Jetson Xavier NX可以快速处理来自多个高分辨率传感器的流式数据。

具备云原生功能的Jetson Xavier NX已获得嵌入式生态系统的大力支持。Jetson Xavier NX开发者套件和Jetson Xavier NX模块现正通过NVIDIA分销渠道进行发售,售价399美元。

NVIDIA开发者大会,每次都有新产品推出,所以还是那句话:“The More U Buy, The More U Save。”

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第2310期内容,欢迎关注。

『

半导体第一垂直媒体

』

实时 专业 原创 深度

识别二维码

,回复下方关键词,阅读更多

政策|海思

|集成电路

|

AI

|CMOS

|晶圆|ARM|射频|台积电

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复

搜索

,还能轻松找到其他你感兴趣的文章!

责任编辑:Sophie