算力即服务,首个基于RISC-V算力的行业大模型生态系统问世

2024-10-24

11:00:31

来源: 互联网

点击

近年来,我国始终将“数字化”“智能化”摆在关键位置,一再强调加快数字经济发展,推进数字产业化、产业数字化,推动互联网、大数据、人工智能和实体经济深度融合。

2022年OpenAI发布的ChatGPT及其背后的GPT系列预训练基座大语言模型,引领了从判别式小模型转向生成式大模型的发展热潮。各行各业纷纷尝试借助基座大模型打造垂类大模型行业应用,期望给业务带来新的突破,同时又深深担心算力供应的稳定性和安全可靠性。

广州希姆半导体科技有限公司(后文中简称希姆计算)作为一家致力于研发AI领域专用架构处理器的公司,始终深耕RISC-V路线并以商业落地为导向,是少数从芯片指令集到上层应用全面布局的创新型企业。随着大模型的火热,希姆计算敏锐的觉察到各行业对优质且安全可靠算力服务的需求,积极跟进AI行业前沿技术并落地行业应用,旨在基于RISC-V本身强大的自主可控标准化优势通过软硬一体的大模型解决方案为政企客户的数智化转型赋能。

大模型、智能体、数据治理——政企场景落地的关键

在数智化转型的大潮中,政企面临着处理与分析海量数据的挑战,并且普遍存在业务逻辑复杂、定制化要求高、部门协同难度大、数据壁垒难以打破等困难,单一技术手段难以应对这种复杂的业务场景,亟需平台级产品促进业务发展、提升竞争力。

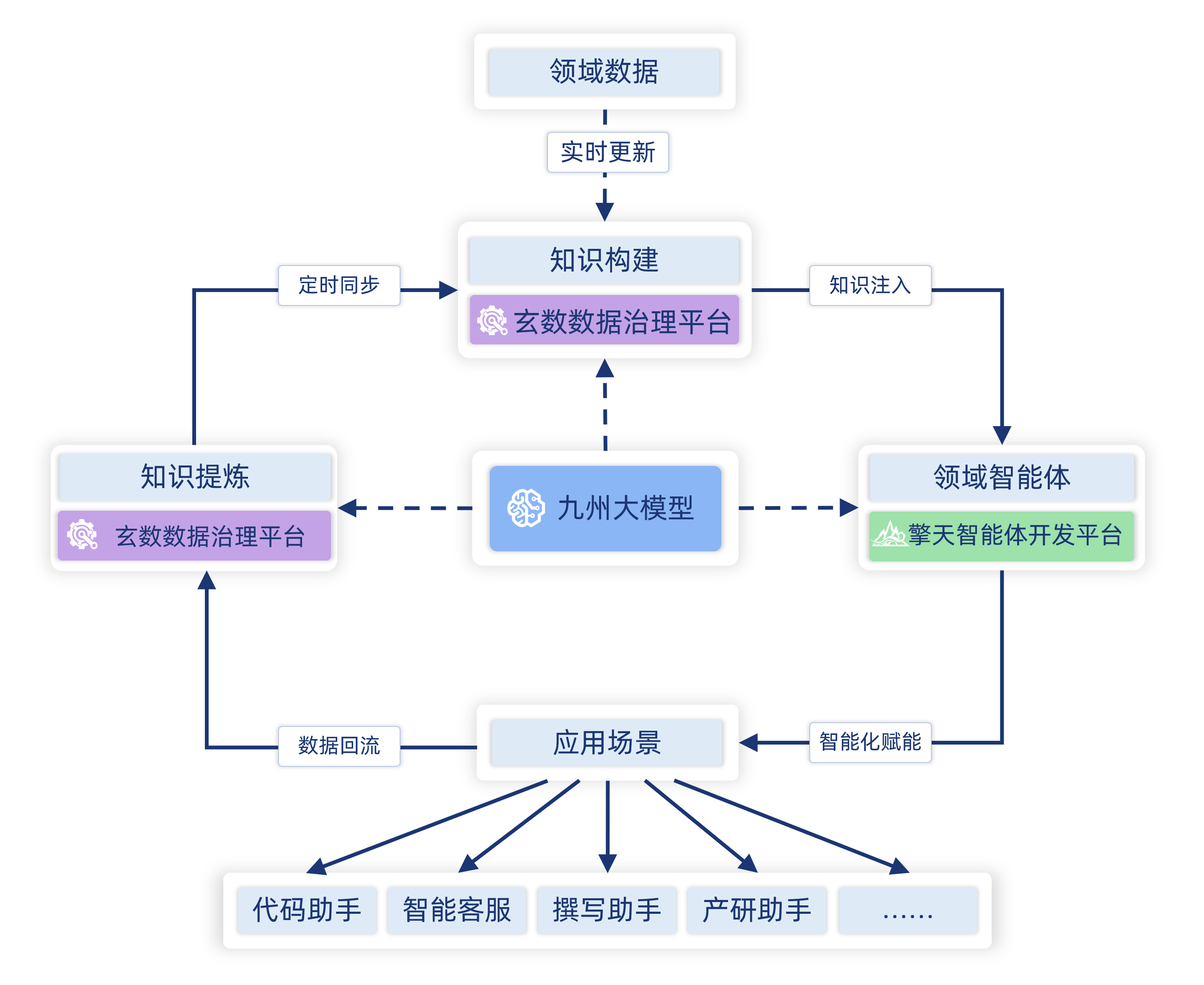

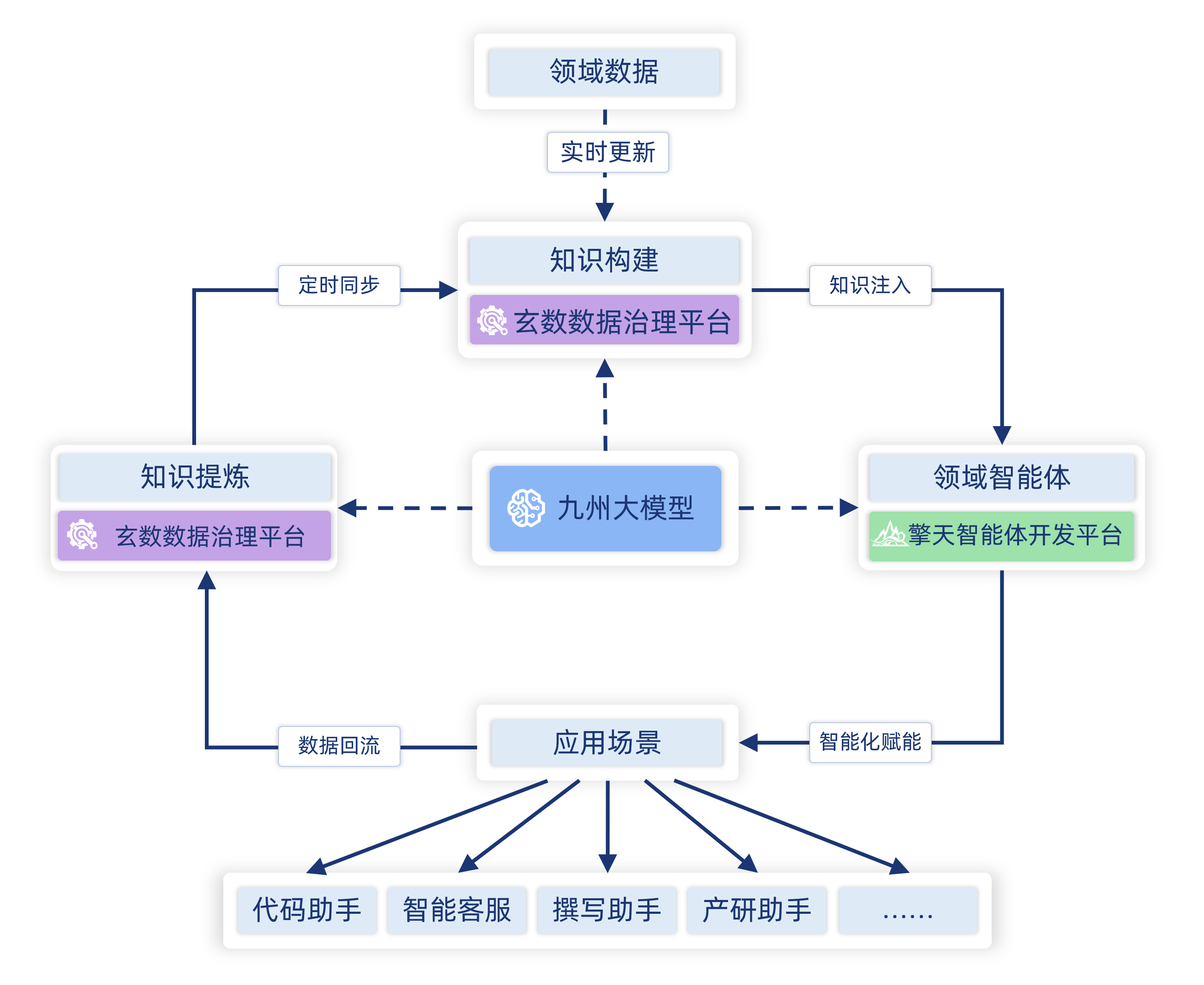

经过对政企场景进行了深入调研,希姆计算设计开发了希姆九州大模型(后文中简称九州)、希姆玄数数据治理平台(后文中简称玄数)以及希姆擎天智能体开发平台(后文中简称擎天),三者相辅相成,共同构建了一个高效的数据处理生态系统,覆盖了大模型应用开发的完整生命周期,不仅解决了单一技术手段难以应对复杂业务场景的问题,而且极大地促进了从数据到价值转化的过程。

这套系统有机结合共同解决基座大模型应用中常见的“幻觉问题”,满足政企业务对准确率的苛刻要求,推动政企数智化转型,提升整体竞争力。

九州是面向政企领域的垂直大模型,基于20亿条垂直领域与开源语料深度训练而成,不仅掌握了丰富的通用知识,还特别强化了对垂类场景的理解,能够精准把握地方政策法规、理解业务场景意图并生成相关内容。在企业内部管理、客户服务、产品推荐,数据检索查询等场景中,九州能够更准确地理解企业特定的业务需求和术语。

九州不仅助力政企数字化转型,提升业务质量,还实现了一种全新的知识沉淀的机制来帮助业务部门更高效和透明的提供服务。

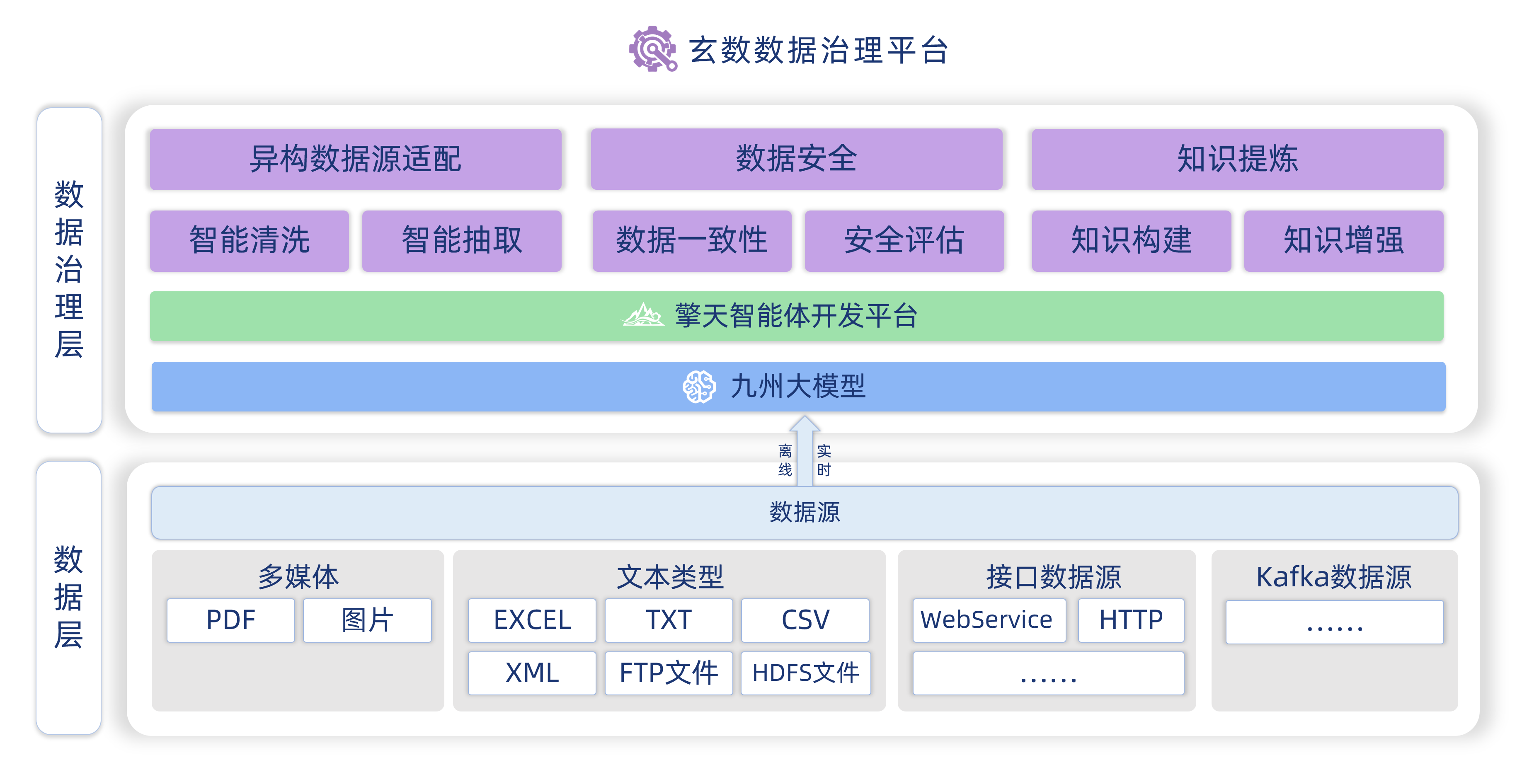

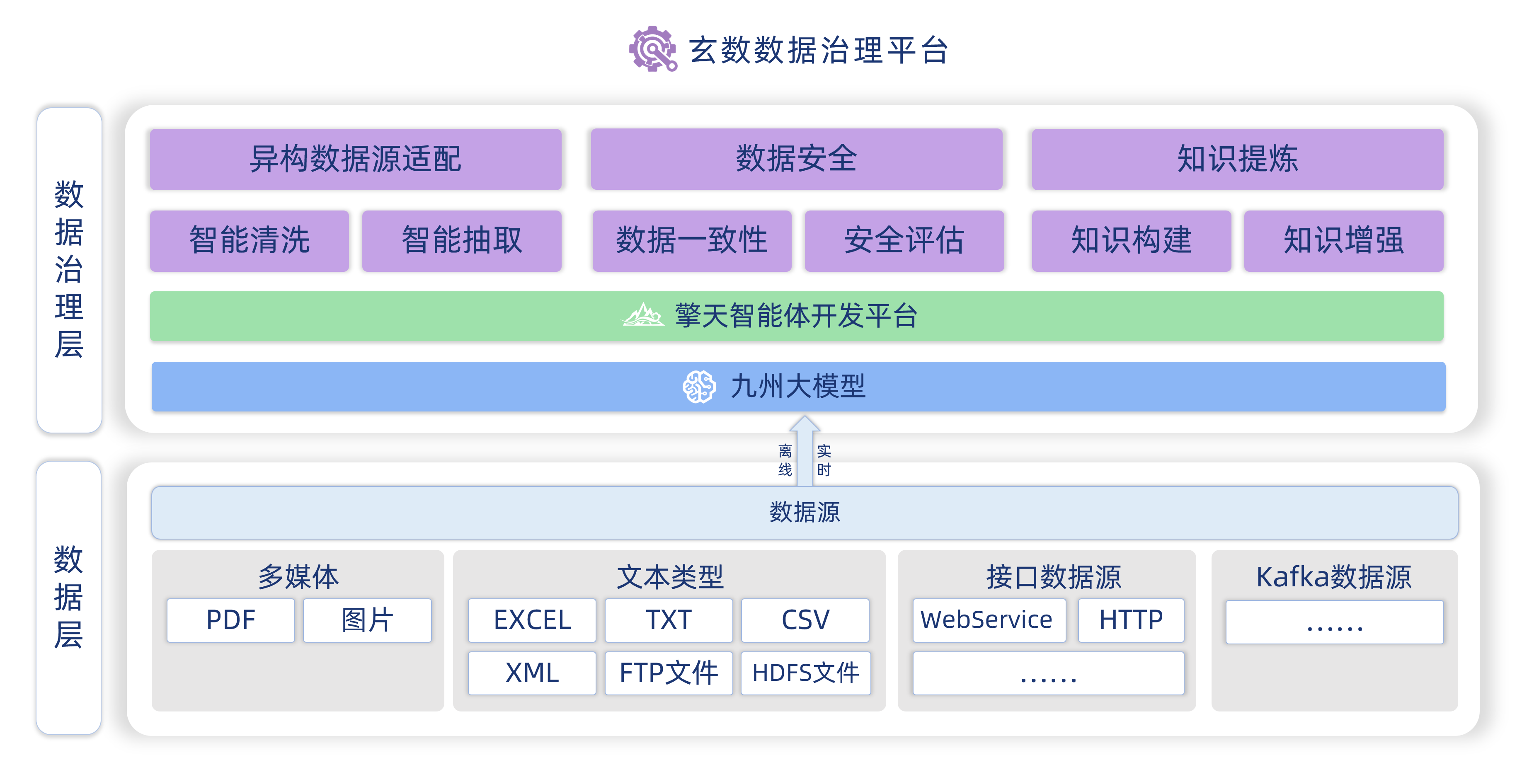

玄数集成了强大的数据智能抽取与知识增强功能。通过实体抽取、关系抽取、属性抽取及属性对齐技术,玄数能够高效地从非结构化和半结构化数据中提取关键信息。此外,利用属性增强和关系增强技术,可以进一步丰富和完善数据的知识体系,提升数据的可用性和价值。

玄数兼容诸多大小模型,涵盖了自然语言处理(NLP)、自然语言生成(NLG)及命名实体识别(NER)、OCR等多个领域的任务,确保平台在文本理解、内容生成、信息检索等方面的卓越表现。客户可以轻松实现数据资产的价值最大化,促进业务流程优化与决策支持。

擎天作为业界领先的智能体开发平台集成了智能体构建、知识管理、工作流编排等核心功能,通过结合九州和多种小模型(如BERT、Embedding和Rerank模型),提供高效、精准的数据处理和服务能力。在工作流编排模块提供了丰富的交互界面和接口,支持快速在搭建各种业务场景的工作流,同时支持低代码开发。

而在Agent开发管理方面,擎天兼容主流的Agent开发范式,可以帮助政企客户快速搭建高阶智能体应用。在知识管理方面,擎天除了支持标准的向量数据库,还结合政企场景的业务提供了先进高效的知识图谱检索算法,从而提高推理的准确性和可靠性。

希姆计算基于擎天、九州、玄数平台,为广州市黄埔区开发了智能政务问答助手,利用政务图谱能够从海量的政务公共数据中提炼关键信息,在落地中涵盖了37个政府部门的2000余项事项以及数千份政策文件和指南。无论是政策咨询还是具体办事流程,该助手都能根据政务图谱提供准确的答案。

相比传统的问答助手,该助手将政务咨询准确率从30%左右提高到95%以上,办事体验更加流畅自然,减少了对人工客服的需求,促进了政务知识沉淀。相对于传统软件系统,智能体可以更好的服务业务应用。

服务政企客户的经验来之不易,在研发过程中面临着诸多挑战,研发副总裁王得科说:“政企垂直场景的挑战是要做一个真正‘懂’业务的智能体,我们不仅提供了一套智能系统,也为客户引入了一种全新的工作模式。这一过程要求我们对客户的业务有深入的理解,并将这种理解深度结合到大模型应用的开发实践中。”

支撑一个AI应用,需要多少技术栈

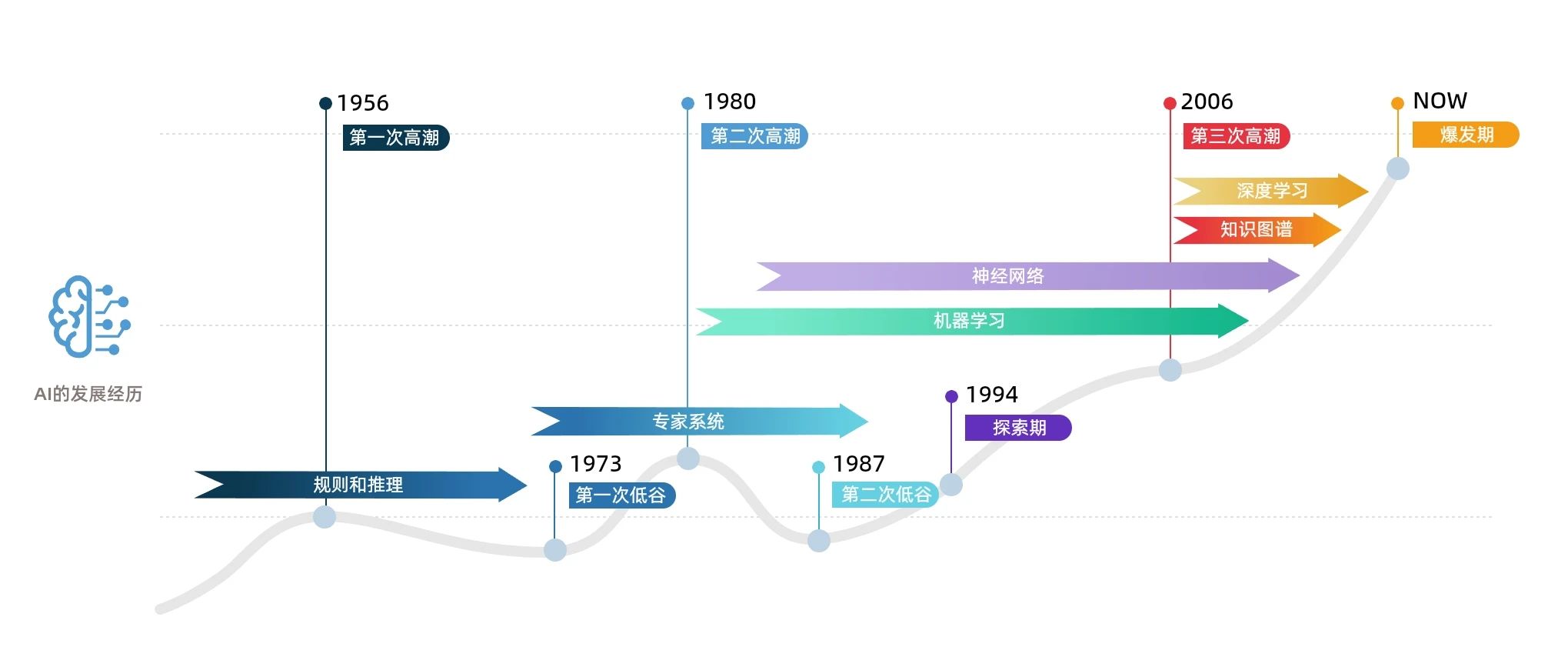

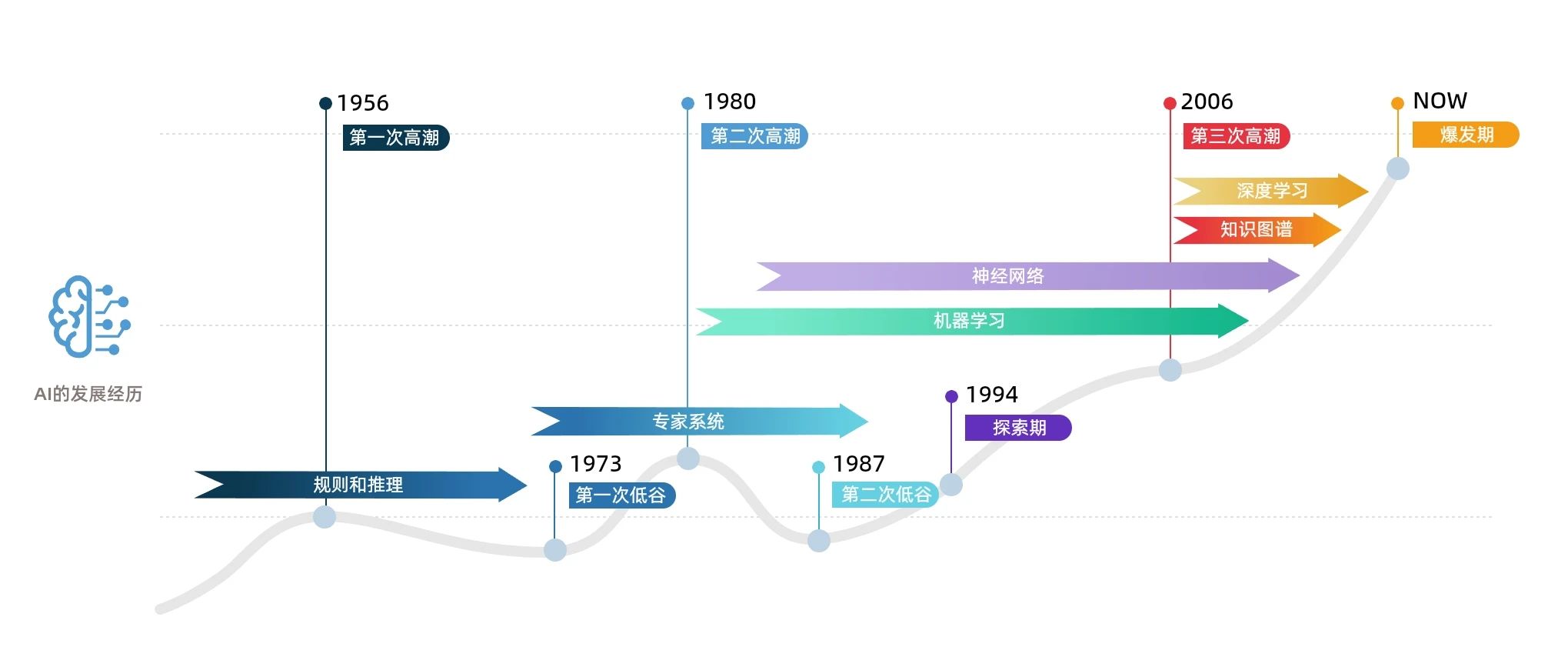

AI的发展经历了数次高潮和低谷,在第三次高潮中深度学习是主流的技术路线。随着ChatGPT印证了Scaling Law以及随之产生的智能涌现能力,大模型的智能上升到了前所未有的量级,其背后采用的Transformer算法和预训练大模型的生成式AI技术,让这股发展势头达到了前所未有的高度,大模型的规模也屡创新高。

大模型规模的增长不断刷新着算力需求的上限,随之而来的算力焦虑正在困扰整个行业。如果说AI应用是露出海面的冰山一角,支持AI应用以及大模型的算力解决方案、智算集群乃至AI芯片就是冰山稳稳浮起的底层保障。

希姆计算从公司成立伊始就坚持软硬一体自主可控的发展方向,支撑九州、玄数、擎天的底层核心软硬件全链路自主研发,基于自研AI计算矩阵扩展指令集设计了STCP920芯片、推理卡以及配套软件,为智算中心量身定制了希姆智算云平台,提供了落地大模型应用的RISC-V创新方案,是RISC-V软硬一体技术创新的代表性企业。

RISC-V,数智时代的天选之子

如果说x86架构是抓住了个人PC普及的机遇,ARM抓住了移动时代的浪潮,那么当前随着AI等技术的快速发展,RISC-V迎来新的发展浪潮。

政企业务需要稳定高效灵活的算力基座,自主可控的底层技术,长期安全可持续的发展路径以及逐步繁荣和国际接轨的生态体系。RISC-V+AI完美的满足政企业务的这些需求,是解决当下AI算力焦虑的最佳方案,也是我国独立发展大芯片的重要技术路线。

希姆计算在创业时就瞄准了基于RISC-V研发AI领域专用架构处理器的切入点,突破了SIMD向量指令、GEMM通用矩阵计算以及深度学习模型中的算子计算加速等技术难关,自主研发并在全球范围内率先开源了AI计算矩阵扩展指令集,完成了基于RISC-V指令集的标量、向量、张量的一体化指令集架构,也形成了自身的核心竞争力。

凭借对RISC-V生态发展的深度参与和贡献的技术成果,希姆计算获得了行业的高度认可,先后被接纳为RISC-V国际基金会最高级别会员、RISC-V董事会成员单位、RISC-V TSC技术委员会成员单位、RISC-V软件应用与工具委员会主席单位,RISC-V AI/ML专委会主席单位和RISC-V Matrix TG核心成员单位。

同时希姆计算在国内积极推进RISC-V的广泛应用,先后当选中标协RISC-V工作委员会副会长单位、中国智能计算产业联盟副秘书长单位,以及全国信息技术标准化技术委员会-人工智能分技术委员会单位委员和多样性算力产业及标准推进委员会成员单位。

基于一体化指令集架构,希姆计算实现了NeuralScale NPC核心架构,并推出了STCP920芯片和推理卡。STCP920推理卡是面向云端AI推理计算的板卡级产品,具有高能效、低延时等优势,可广泛应用于需要AI推理加速的场景中。

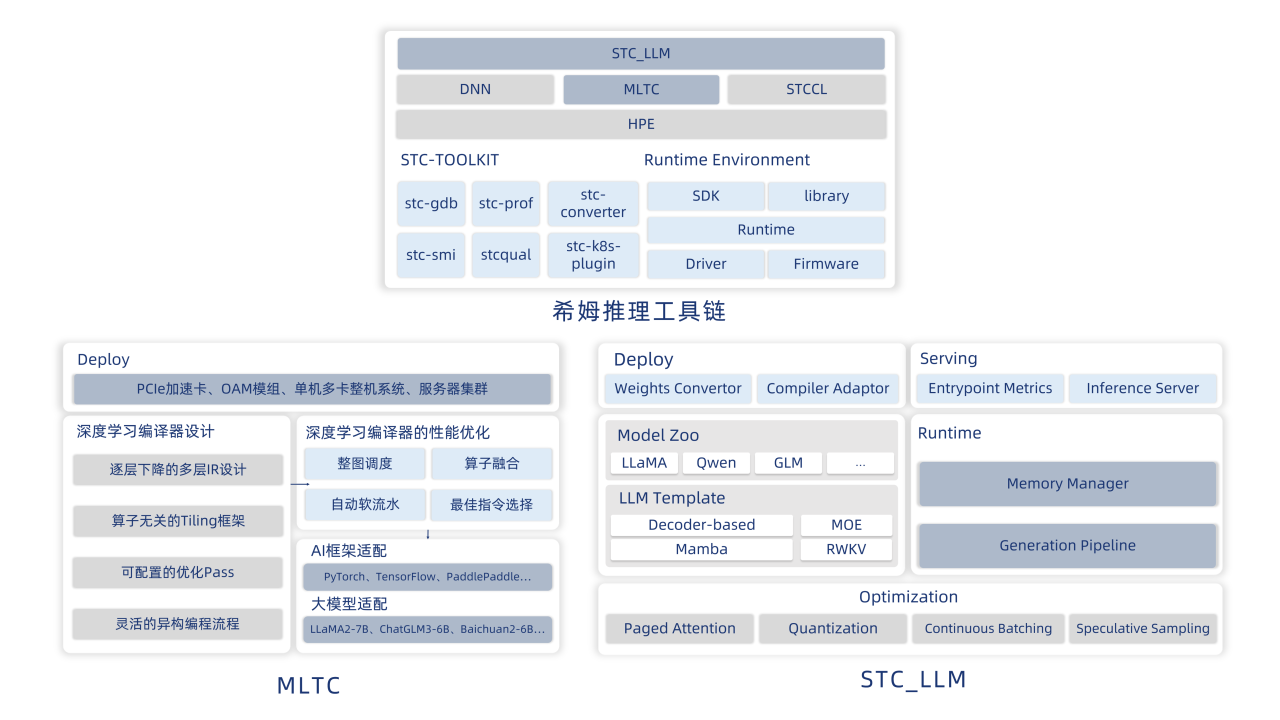

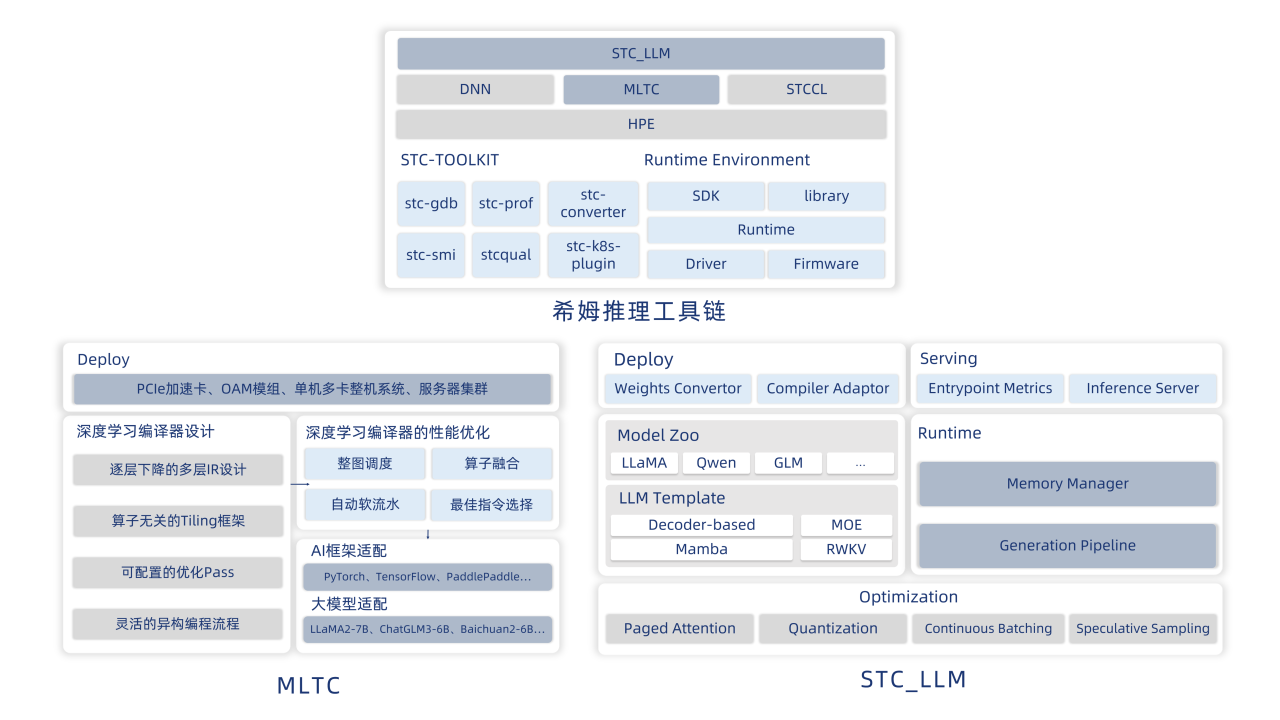

此外,希姆计算针为STCP920研发了完整的软件工具链,充分发掘指令集的优势及硬件的潜力,覆盖了深度学习模型的开发、部署、运维全流程,有力的支撑了上层业务。

针对常见的深度学习模型,希姆计算提供了MLTC编译器套件,通过先进的多层IR设计搭配先进的自动优化技术,不仅能够兼容不同格式的深度学习框架,同时可以使得这些模型在希姆计算的硬件上达到最佳性能水平。

而针对大模型,希姆计算亦开发了专用的推理加速框架 STC_LLM,根据大模型的特点,在Kernel层、调度层引入了多种大模型专用的优化技术,大大提升了大模型的推理表现,最高可以提升300%的性能。

智算中心,高效释放算力价值

AI加速卡的理论算力往往是大家最关心的一项指标,也是各大厂商发布产品时宣传的重点,但是理论算力并非客户最终能用到的算力。对于大模型的大规模算力需求,往往通过智算集群来满足,绝不是卡的简单堆砌,更加强调软硬协同的系统、全栈解决方案中各层级的优化功力以及最终的算力服务质量。

希姆计算始终以商业落地为导向,无论是硬件产品还是软件产品,设计之初就朝着端到端全栈解决方案的方向齐头并进。研发副总裁王得科表示:"打造全栈解决方案是一个漫长而复杂的过程,要求我们从算力即服务的角度出发,为各个产品和功能设计合理的边界。”

希姆计算以算力即服务为交付理念,通过成熟的软件生态,简化模型部署的链路,降低客户开发AI应用的复杂度,对信创/非信创的软硬件生态均有良好的适配和支持,帮助客户打通从模型开发到部署的最后一公里,方便一键式发布、部署模型服务。

希姆智算云平台是希姆计算面向智算中心研发的专业算力平台,旨在有机调动智算集群中的计算、网络、存储资源,形成云上随用随取的AI算力,应对当前AI算力中心建设中标准不一、技术深度不足、交付周期冗长等一系列挑战。

智算云平台的设计采用了云原生的理念,通过容器化部署、微服务架构、分布式存储和计算资源的动态调度等技术,可以支持超大规模集群的部署,最高支持万卡规模的集群,典型场景下可以做到秒级切换,深度学习负载可以达到90%以上的利用率,充分发挥硬件能力。

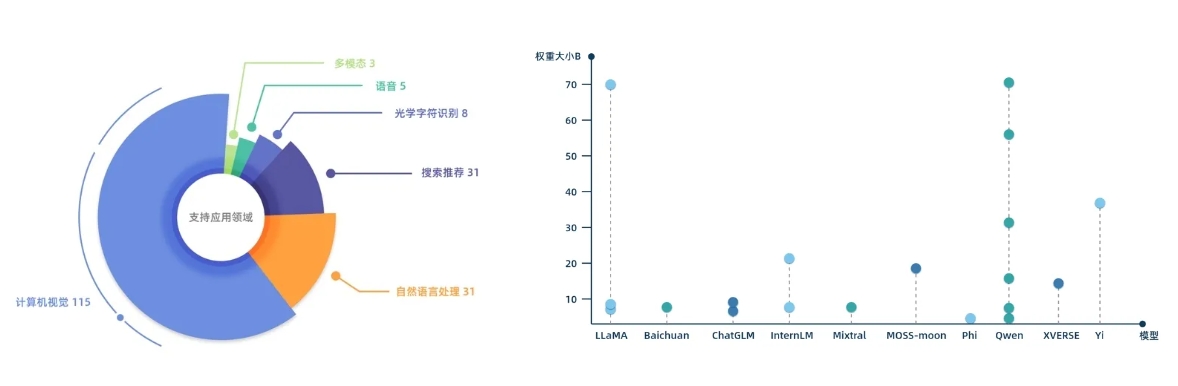

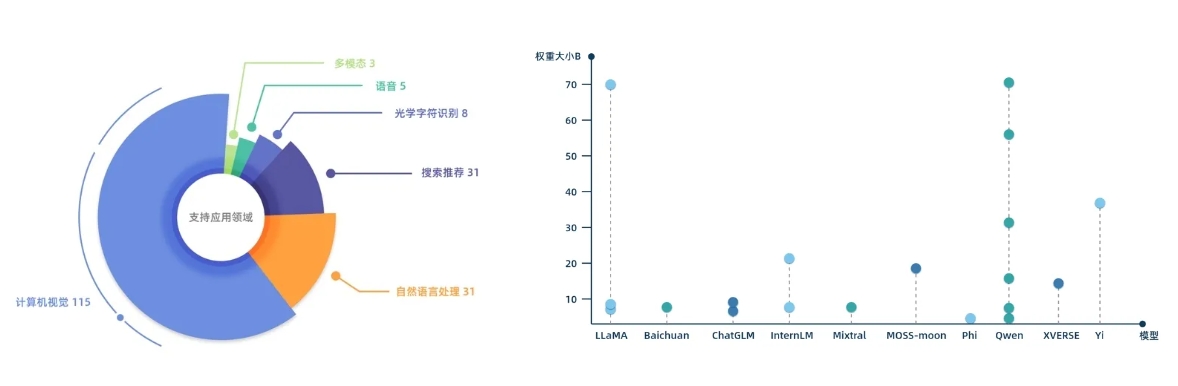

希姆计算充分考虑了国内外的模型生态和落地场景,建设了高度适配自研硬件的模型仓库STC-ModelZoo,为客户提供开箱即用的各类SOTA模型,包含了传统的计算机视觉CV、自然语言处理NLP、搜索推荐、语音、多模态等模型200余个,以及当前热门的各种开源大语言模型,LLaMA、Qwen、Baichuan、ChatGLM、InternLM、Mixtral、MOSS-Moon、Phi、XVERSE、Yi等系列30余个,参数量规格从几B到几十B不等。

针对私有模型,希姆计算提供了转换工具(STC-TOOLKIT),帮助客户方便地迁移至希姆计算生态,快速部署私有模型,大大降低迁移成本。

目前,希姆计算已经在全国各地成功落地了多个智算中心项目,有力支撑了各种 AI 应用,包括AIGC、问答助手、内容创作、缺陷检测、安全施工、烟火报警、交通研判、医疗诊断、内容审核、语音识别等,全面覆盖了互联网、智慧办公、智慧城市、智慧工业、智慧金融、智慧医疗等热门领域。

希姆计算, AIGC时代软硬一体解决方案的领导者

从ChatGPT的横空出世,到国内外厂商纷纷入局大模型“百模大战”,再到智算中心的火热建设,现如今才过去了不到两年的时间。AIGC技术已经在颠覆生产内容的方式,迅速在众多领域重塑着生产力关系。行业的发展日新月异,对优质产品的需求日趋精细,更要求企业持续加强自身核心竞争力,审视自身能够为客户提供的价值。

在RISC-V+AI这条赛道上,希姆计算从自研关键的AI计算矩阵扩展指令集切入,通过先进的核心架构和推理加速产品,以及完整的软件工具链,为自主可控地提供算力服务夯实了软硬件基础,并且明确自身做为算力技术提供者、推进行业智能化转型的定位,基于自身算力平台率先打造出了成熟的垂直大模型、智能体、数据治理产品。

这些产品的成功体现了希姆计算从硬科技创新到场景化落地的综合实力,在RISC-V创新方案上抢先了一个身位,也是希姆计算赖以发展壮大的基因。

未来,行业对算力的需求没有止境,不断创新和突破瓶颈是企业和行业永远的使命。对希姆计算来说,当前的全栈解决方案只是阶段性的成果。创新,永远在路上,点滴积累才能汇聚成创新的土壤。未来无论是打磨既有方案落地更多场景,还是将沉淀的经验融入开发中的下一代芯片,以及推进AI方向的国际技术标准制定和生态合作,希姆计算都将为行业的发展注入新的可能。

责任编辑:Ace

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻

最新新闻

热门文章 本日 七天 本月

- 1 MediaTek 发布天玑 8400 移动芯片,开启高阶智能手机全大核计算时代

- 2 探索智慧实践,洞见AI未来!星宸科技2024开发者大会暨产品发布会成功举办

- 3 汽车大芯片,走向Chiplet:芯原扮演重要角色

- 4 国产EDA突破,关键一步