来源:

本文由半导体行业观察翻译自TSMC博客,文章作者台积电全球营销主管Godfrey Cheng,谢谢。

我加入台积电已近3个月了。

和任何加入新公司的人一样,我一直在吸取着大量的信息和数据。

我最初挖掘的一个关键主题是摩尔定律,它的原来的理念是:

集成器件或芯片中的晶体管数量大约每2年增加一倍。

在我看来,摩尔定律实际上是被误称为一种定律,因为更准确地说,我们可以将其看作是对半导体器件或芯片中晶体管数量的历史观察和未来预测的指导。

这些观察和预测在过去几十年中基本上都是正确的。

但在我们接近新的十年时,一些人似乎认为摩尔定律已经死了。

因为有些人将摩尔定律定位为在相同面积下,芯片的性能每两年翻一番。

多年来,特别是在CPU和GPU的开发中,这似乎是正确的。

从20世纪70年代到2000年初,晶体管时钟速度实现了从单兆赫到几千兆赫的爆炸性增长。

然而,自2000年以来,计算性能大大提高,但这不是通过提高晶体管时钟速度,而是通过硅架构创新和计算工作负载的线程化或并行化。

已经开发了CPU和GPU的公司已经通过进一步的架构创新和添加更多计算核心来响应此软件并行化。

通过上面的示例我们可以看到,由于单个晶体管时钟速度,计算性能没有提高,然而计算性能通过在计算时引入更多晶体管而得到改善。

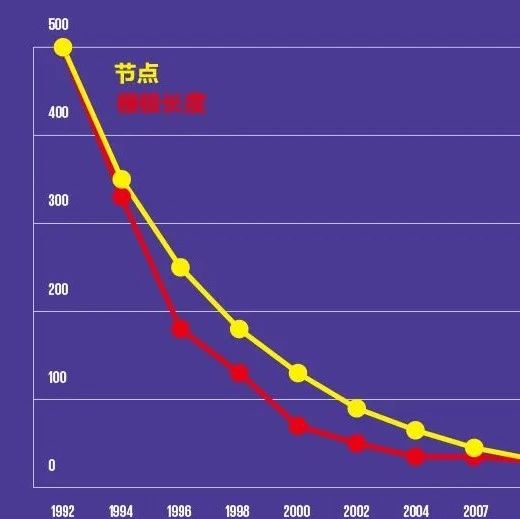

在同一区域放置更多晶体管的措施是什么?

那当然就是密度!

所以说摩尔定律是与密度有关的!

所谓密度的含义大约是给定二维区域中晶体管的数量。

我们为什么关心芯片面积?

因为芯片成本与芯片面积成正比。

摩尔在1965年发表的论文在图1中清楚地表明,每个元件的制造成本与芯片上晶体管的总数之间存在关联。

让我们来探讨一下我们今天看到的一些计算问题,以及密度的改进将如何继续提高性能。

有些人认为摩尔定律已经死了,因为他们认为不再可能再继续缩小晶体管。

为了让您更深入了解,我们来先看一下现代晶体管的规模。

数字显示,当下典型的晶体管栅极长约20纳米,而水分子的直径仅为2.75埃或0.275纳米!

这样您现在可以开始计算晶体管中的原子数。

在这种规模下,许多因素限制了晶体管的制造,其中主要挑战是在原子水平上控制材料。

例如如何放置单个原子来制造晶体管?

特别是在现代芯片上,你如放置这数十亿个晶体管呢?

如何以经济高效的方式构建这些具有数十亿个晶体管的芯片?

这些问题会一直缠绕着芯片制造工程师。

为了解决这个问题,台积电最近宣布了我们的N5P节点,这进一步扩大了我们在N5节点之外的领先地位,N5节点将具有世界上最高的晶体管密度并提供最快的性能。

在接触到我们的技术路线图后,我可以放心地说台积电在有多年的开拓和创新,我们将继续缩小单个晶体管并继续提高密度。

随着我们进入新节点,您将在未来几个月和几年内听到更多来自我们的消息。

除了单个晶体管之外,我们还需要查看系统级密度。

回顾并观察CPU和GPU的经典计算任务,现代芯片具有极快的晶体管时钟速度,接近5千兆赫兹甚至更高。

这些计算任务的核心挑战实际上是保持CPU和GPU内核的数据。

虽然这通常是一个软件挑战,但现代架构和线程方法已经直接将性能瓶颈置于硬件层面。

这让我们终于看到了大数据分析和人工智能时代内存缓存的局限性。

为了满足现代快速CPU,GPU和专用AI处理器的需求,除了为要处理的内核提供更高带宽的数据外,提供物理上更靠近数据的内存至关重要,因为这能解决高延迟的问题。

这就是设备级密度所提供的。

当存储器靠近逻辑核心并置时,系统可实现更低的延迟,更低的功耗和更高的整体性能。

你们中的一些人可能认为这是系统级别的问题,而不是设备技术的内在属性。

这在过去可能是严格正确的,但是在芯片的定义和系统的定义之间已经变得模糊。

该线将继续变得更加模糊,并最终完全消除。

我们现在已经从设计技术协同优化(DTCO)时代转变为系统技术协同优化(STCO)。

通常,逻辑核心通过诸如DDR或GDDR之类的接口与独立存储器芯片通信,但随着存储器设备和逻辑核心之间的物理距离的增加,延迟问题越来越严重,进而影响了性能。

带宽也受限于离散存储器,因为它们仅提供有限的接口宽度。

此外,分立逻辑和存储器的功耗也决定了器件的整体性能,特别是在智能手机或物联网设备等应用中,因为散射分立器件辐射的热能的能力有限。

其他如机器学习,包括培训和推理等应用正在推动功率,带宽和延迟的边界。

人工智能(AI)通常被视为一种计算问题,但AI其实有两个不同的方面:

训练(机器学习)和推理。

要使任何AI系统工作,必须首先训练神经网络。训练需要密集的计算操作,例如前馈(Feed-Forward )和反向传播(Back-Propagation),其中逻辑核心被送入大量数据。逻辑内核的送入速度越快,学习速度就越快 ,为此带宽在这里至关重要。因为训练神经网络的行为消耗了极大的能量,所以许多人担心数据中心和人工智能训练带来大量的能量损耗。而大部分能量实际上是由内存和内存接口消耗的。但通过用逻辑核心打包内存,这样就能减少来自内存带宽的消耗。

AI 推理是经过训练的神经网络在现实世界中的应用,这是在Edge的计算。

一旦您拥有经过训练的神经网络,Edge设备就需要使用训练并在尽可能短的时间内执行其任务。

需要改进延迟的一个明显示例是在自动驾驶汽车中发现的图像分类器神经网络。

对于ADAS 2+汽车的乘客的操作和安全而言,具有低延迟和快速执行神经网络以识别威胁是至关重要的。

当汽车以高速公路的速度行驶时,每毫秒都需要安全。

因此,定位内存关闭边缘处理核心对于减少延迟至关重要。

TSMC现在已经可以通过先进的封装技术将逻辑内核与存储器紧密集成。

半导体和系统解决方案之间的界限也越来越模糊,因为新的先进封装技术是基于硅芯片的。

台积电率先采用先进的封装技术,使我们的客户能够提供基于硅的nterposer或基于扇出的chiplet集成完整的系统。

我们还拥有先进的封装技术,使我们能够在集成到封装模块之前将芯片堆叠在晶圆上或在晶圆上堆叠晶圆。

这些先进的封装技术使TSMC客户能够提供更高的密度和更高的性能。

我们将继续推动先进封装技术的创新。

摩尔定律是关于增加密度。

除了通过先进封装实现的系统级密度,TSMC将继续在晶体管级别增加密度。

TSMC有许多路径可用于未来的晶体管密度改进。

一条可能的前进道路是使用由二维材料而不是硅制成的晶体管作为通道 。

我们正在“研究”周期表,希望通过潜在某些些新材料,实现密度改进的一个可能未来——那就是允许在我们称为单片3D集成电路的东西中堆叠多层晶体管。

您可以在AI Edge引擎顶部的GPU顶部添加CPU,其间有多层内存。

摩尔定律并未死亡,因为我们有许多不同的途径可以继续增加密度。

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第2038期内容,欢迎关注。

『

半导体第一垂直媒体

』

实时 专业 原创 深度

识别二维码

,回复下方关键词,阅读更多

射频|台积电|江北新区|AMD|FPGA|EDA|集成电路|MRAM

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复

搜索

,还能轻松找到其他你感兴趣的文章!