[原创] 这家AI芯片公司将成为英伟达GPU的最强挑战者

Habana Labs推出了Gaudi HL-2000,这是一款定制的AI处理器,该公司声称,Gaudi HL-2000能够在训练神经网络方面超越英伟达最优秀、最亮眼的GPU。随着新芯片的发布,这家位于特拉维夫的初创公司推出了一系列基于Gaudi的PCIe卡,以及一个八处理器服务器,可用作构建超大型训练集群的基础。

Gaudi代表着Habana进军AI市场的第二次尝试。2018年第四季度,该公司开始向客户出货Goya推理卡。正如我们当时报告的那样,与英伟达的V100 GPU相比,HL-1000驱动的Goya在ResNet-50上进行推理时,提供了超过4倍的吞吐量,2倍的能源效率,以及一半的延迟。据Habana首席商务官Eitan Medina称,Habana已经收集了近20名Goya客户,他们目前正在评估这项技术。

新的HL-2000在周一发布,与HL-1000对应。同样,使用ResNet-50,Gaudi演示了它可以达到每秒1,650张图像,批量大小为64。(对于V100,我们可以找到的最佳训练结果是每秒1,360张图像,批量大小不详。)Medina对The Next Platform讲:“让我们在小批量的情况下实现这种性能的基本属性与核心架构有关——它是从头设计的,而不是依赖于老架构,比如GPU或经典CPU。”

Habana并没有提供太多关于芯片内部细节的信息,只声称它是基于第二代Tensor处理核心(TPC),第一代进入了他们的推理芯片。Medina告诉我们,Gaudi处理器支持用于训练的典型浮点格式,如FP32和bfloat16,以及一些整数格式。On-package memory采用32GB HBM2的形式,反映了GPU加速器上可用的内容,比如英伟达的V100和AMD的Radeon Instinct MI60。

Habana没有透露新处理器的任何原始性能数据。Medina解释说:“如果我告诉你我在芯片上放了多少个乘法器,以及它们的工作频率,但是这个架构却不允许你使用它们,那么我所做的一切都是在误导你。”据他介绍,由于他们的clean-sheet设计,他们的芯片可以实现比GPU更高的利用率。

也许Gaudi最大的潜在优势将是提供大规模性能的能力,这对于构建更大、更复杂的神经网络一直是一个挑战。对于大多数训练设置,一旦超过8个或16个加速器,也就是说,一旦离开服务器机箱,性能就趋于平稳。Medina说,Gaudi的技术并非如此。他指出,同样的ResNet-50训练扩展到数百个HL-2000处理器,其性能接近线性增长。与V100相比,Habana技术能够在650处理器的水平上提供3.8倍的吞吐量优势。

Habana通过在他们的Gaudi芯片中插入大量网络带宽,以RDMA over Converted Ethernet(ROCE)的形式实现这一点。使用以太网(而不是NVLink或OpenCAPI等更奇特的东西)的理由是,它使客户能够轻松地将Habana硬件放入现有的数据中心,以及使用各种网络提供商提供的标准以太网交换机构建AI集群。

在HL-2000处理器的情况下,10个100GbE接口集成在芯片上,其中一些接口可用于连接节点内的其他HL-2000处理器,其余接口可用于跨节点的处理器内通信。后一个功能消除了对NIC的需求。

在Habana自己的HLS-1系统中可以看到这种工作原理,这是一个配备8个HL-2000处理器的类似3U DGX的盒子。在内部,每个芯片的100GbE链路中有7个用于以无阻塞、all-to-all的方式将HL-2000处理器连接到另一个处理器,而其余3个链路则提供给服务器以构建更大的集群——因此有24个100GbE外部端口。连接到主机服务器或闪存不会占用以太网带宽。为此,Habana提供了4个PCIe Gen4 x16接口。

将其与典型的GPU加速服务器进行对比,后者通常受单个网络接口的限制。在这方面最好的是英伟达最新的16 GPU DGX-2系统,它配备了多达8个100G端口,但这仍然是24端口HLS-1提供的一小部分。

Habana Gaudi系统的机架可以通过将6台HLS-1服务器与6台CPU主机服务器(HLS-1没有主机处理器)穿插在一起,再加上机架顶部的以太网交换机来构建。这样的机架可以连在一起构建任意大的集群。虽然没有板载主机处理器可能会让一些人感到厌烦,但它确实允许客户选择CPU的型号和品牌,并让他们能够微调CPU核心与AI加速器的比例。

想要构建自己的基于Gaudi的系统的客户可以使用Habana的HL-200 PCIe卡,它提供8个100GbE端口,或HL-205夹层卡,它有20个56Gbps SerDes接口,足以支持ROCE形式的10个100GbE或20个50GbE端口。HL-200的功耗为200瓦,而HL-205的功耗则为300瓦。

夹层卡是Habana的HLS-1服务器的基础。但也有可能用它来构建更大的系统。例如,如果你降低到50GbE以便在机箱中进行all-to-al连接,则可以使用16个HL-205卡构建16个处理器的机箱,仍然留下32个100GbE端口以进行扩展。如果你想构建一个较小的服务器,则可以在一个机箱中以菊花链形式连接多达8个HL-200卡。

顺便提一下,夹层卡支持OCP加速器模块(OAM)规范,这是一种开放硬件计算加速器模块形式,开发了Facebook、微软和百度。这告诉了我们Habana瞄准这个特定产品的许多地方。

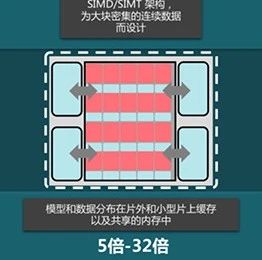

与英伟达对NVLink所做的不同,Habana不支持跨多个处理器的缓存一致的全局内存空间。Gaudi设计师认为缓存一致是一种性能杀手,无法有效扩展到少数加速器之外。从他们的角度来看,实现训练神经网络的可扩展性基本上是一个网络问题,使用RDMA可以非常有效地生成更大的模型。

Habana的竞争可能也会转向这种思维方式。正如Medina所指出的,在最近的GTC会议上,英伟达首席执行官Jensen Huang将RoCE作为一种大大提高深度学习工作可扩展性的方法。这意味着,一旦这家GPU制造商的收购在今年晚些时候完成,那么该公司对于利用Mellanox的以太网技术有一些非常具体的想法。

软件方面,Gaudi配备了Habana的AI软件栈,称为SynapseAI。它由图形编译器、运行时、调试器、深度学习库和驱动程序组成。在这一点上,Habana支持TensorFlow来构建模型,但是Medina说,随着时间的推移,他们将增加对PyTorch和其他机器学习框架的支持。

从评估系统到生产部署可能还有很长一段路要走,但如果Habana技术能像承诺的那样交付,AI市场将乐于转向追求更好的性能。尽管如此,在AI硬件方面,英伟达已证明自己是一个快速移动的目标,无论对于初创公司还是像英特尔和AMD这样的老牌芯片制造商而言都是如此。有一点是肯定的:对更大更好的AI的需求正在创造一个高度竞争的市场,在这个市场中,工程团队的灵活执行几乎与架构设计同等重要。

Habana将在2019年下半年向选定的客户提供Gaudi平台。虽然Medina告诉我们,Gaudi将与市场上的同类产品“竞争”,但价格尚未透露。

-

- 半导体行业观察

-

- 摩尔芯闻

最新新闻

热门文章 本日 七天 本月

- 1 ISSCC 2020年论文解析:硅光与电路集成

- 2 蓝牙技术联盟宣布2025蓝牙亚洲大会重磅回归

- 3 英飞凌计划对TRAVEO™ T2G汽车MCU进行ISO/SAE 21434 产品合规认证

- 4 ASML的投资者日,透露了哪些行业发展趋势?