从DPU看大芯片的发展趋势

来源:内容由半导体行业观察(ID:icbank) 转载自公众号软硬件融合,作者:Chaobowx,谢谢。

编者按:

1.1 软件业务和硬件平台分离

-

软件实体可以在不同的硬件平台上运行,可以实时迁移,上层的软件以为软件实体一直是高可用的,感受不到底层硬件的变化(硬件有可能磁盘故障、死机或者是更新服务器等)。 -

完整的单个硬件平台通过虚拟化,可以灵活地切分成许多虚拟的硬件平台,可以支持不同的软件实体运行。

1.2 单服务器的虚拟化、多系统、多租户,全数据中心多集群系统交叉混合

-

首先,通过虚拟化实现多系统多租户共存于单个硬件平台。硬件平台需要支持虚拟化和高扩展性,提供多个个性化的虚拟硬件平台。然后需要支持多个不同甚至迥异的软件系统,运行在各自独立的虚拟硬件平台上。 -

另一个,终端系统当做单个系统的话,那么数据中心服务器则是多个系统混合运行。这样, 我们可以把支持虚拟化多系统多租户运行的服务器运行的系统定义为宏系统。

1.3 物理硬件的一致性和虚拟“硬件”的多样性

-

通过PCIe Switch,连接不同数量不同规格的CPU、GPU以及存储盘、网卡等I/O设备,组成形态各异的多种类型的硬件服务器; -

通过智能网卡、DPU等强大的能力,实现不同规格、不同性能的多计算节点的自由组合; -

还有,通过TOR的功能增强,把许多DPU的工作放到TOR交换机,实现Smart TOR或者TOR-DPU的方式,来实现系统能力的增强; -

其他各种硬件创新项目。

-

计算节点,即服务器,核心功能是计算和各类数据的处理,其网络功能,尽可能只体现在输入输出时的高性能网络。 -

交换机,作为高效的网络核心设备,专注网络的相关处理,尽可能少地参与到用户的计算,保持对用户计算的透明。

2 数据中心处理器:从合到分,再从分到合

2.1 再来学习一下冯诺依曼架构

2.2 第一阶段:CPU单一计算平台

2.3 第二阶段:从合到分,CPU+其他计算芯片的异构计算平台

-

可加速部分占整个系统的比例有限,例如加速占比为80%,则加速最高不超过5倍; -

数据在CPU和加速器之间来回搬运的影响,加速比率打了折扣,有些场景综合加速效果不明显; -

异构加速显式的引入新的实体,计算变成两个或多个实体显式的协作完成,增加了整个系统的复杂度; -

虽然GPU相比CPU性能提升不少,但是相比DSA/ASIC的性能,还是有显著的差距;而DSA/ASIC的问题则在于,无法适应复杂场景对业务灵活性的要求,导致大规模应用成为巨大的门槛; -

CPU+xPU架构,是以CPU为中心,整个IO路径很长,IO成为性能的瓶颈。

-

本质上,每一个CPU+xPU是一个个的孤岛,不同xPU之间的通信会非常的麻烦,都需要CPU的参与,非常低效率低性能; -

在服务器的物理空间里,通常只能加载一种类型的加速卡。不存在这么多的空间,可以加载如此多类型和数量的加速卡。站在服务器功耗约束的角度,这么多加速卡也不允许。 -

以CPU为中心的架构,所有的xPU交互需要CPU的参与(P2P方式可以减轻一些CPU的压力,但至少跨越2条总线交互依然是低效的,本质问题没有解决)。CPU是整个系统的重中之重,随着CPU的性能提升缓慢,CPU成为整个系统的瓶颈,拖累了整个系统整体性能的显著提升。

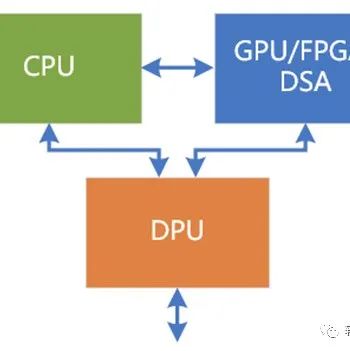

2.4 第三阶段:从分到合的起点:DPU+其他计算芯片的异构计算平台

-

有一种说法,DPU是一个Switch,它不做具体的功能,只是连接了众多的PU。那这样的话,DPU实际上什么事情也没干,这样的DPU没有意义。 -

大家对DPU形成共识的看法,DPU需要支持虚拟化、网络、存储和安全的加速处理。这样的话,DPU本身完成了大量I/O数据的计算任务,减轻了CPU的负担并且显著的提升了整个系统的性能。

-

计算任务,不仅仅包括I/O类任务处理,还可以是其他系统层,甚至可以是应用层的计算任务。如果把DPU当做综合性的计算加速平台,DPU可以继续集成更多的加速功能。 -

DPU代替CPU,成为中心节点,“屠龙少年变成了恶龙”,CPU、GPU、其他xPU之间的通信依然很麻烦,依然是一个个孤岛。 -

如果不更新整个系统的底层架构,以DPU为中心的架构,本质上仍然是以控制为中心的计算,而不是以数据为中心的计算,依然无法达到整个数据吞吐量和计算量的数量级提升。 -

依然存在物理空间约束的问题,服务器空间有限,特别是2U或1U的服务器,也需要足够强劲的算力。而且随着绿色数据中心的流行,对单台服务器的功耗约束势必越来越大。这个时候,各自独立的CPU、GPU以及各类独立加速器的问题就是亟待解决的。 -

从以CPU为中心架构,改成以DPU为中心的架构。会使得DPU成为重中之重,成为系统的关键“瓶颈”,成为系统的不可承受之重。

2.5 第四阶段:从分到合:更高效的融合计算平台

-

超融合是为了把云计算IaaS服务的大集群再整合到小规模集群,这样方便在私有云和企业云部署。 -

而超异构融合芯片则强调系统栈的整体优化,是把服务器上运行的系统整体优化到多种引擎混合的高效高性能的单芯片里。超异构融合芯片既可以支持超融合,也可以支持不融合(即极致解构并超多用户超多系统共存)。

-

控制和管理平面:仍然是运行在CPU的软件; -

计算和数据平面:此刻,CPU、GPU、其他各类xPU,甚至包括I/O都可以看做是平等的各类计算引擎,他们完成各自擅长的工作,并且充分交互,形成一个更加高效更加高性能的的一个整体的系统。

3 大芯片融合的背景条件

3.1 条件1:90%以上的服务器系统相对轻量,单芯片可以容纳

-

边缘服务器。数据中心包括云数据中心和边缘数据中心,据有关数据分析,未来,边缘计算会占到整个数据中心规模的80%。 -

企业级服务器。企业云场景,需要支持虚拟化,但一般来说不需要支持多租户。服务器对算力的需求没有云那么高。也属于轻量级场景。 -

云数据中心服务器大体分为两类,一类是重量级的业务服务器,一类是轻量级的存储、其他各类资源池化服务器。这些资源池化服务的轻量级场景,都可以由超异构单芯片覆盖。 -

此外,独立的超异构融合芯片,也可以作为DPU的角色,和CPU、GPU配合来使用。

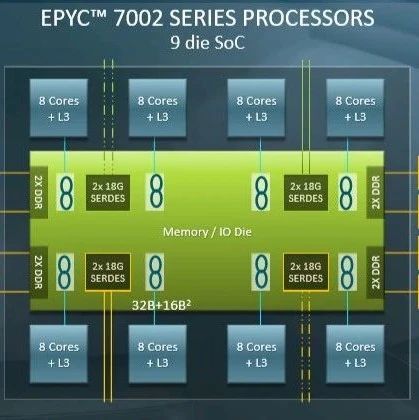

3.2 条件2:Chiplet技术成熟,使得单芯片可以覆盖重量级场景

4 融合,大芯片的发展趋势

4.1 案例:NVIDIA Bluefield DPU集成GPU

4.2 案例2:NVIDIA自动驾驶Atlan超异构融合芯片

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第3132内容,欢迎关注。

推荐阅读

★ GPU市场的转折

半导体行业观察

『 半导体第一垂直媒体 』

实时 专业 原创 深度

识别二维码 ,回复下方关键词,阅读更多

晶圆|集成电路|设备 |汽车芯片|存储|台积电|AI|封装

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复 搜索 ,还能轻松找到其他你感兴趣的文章!

-

- 半导体行业观察

-

- 摩尔芯闻