芯片功率奔向1000瓦,冷却成为头号问题

来源:内容由 半 导体行业观察(ID:icbank) 编译自日经亚洲评论 ,谢谢。

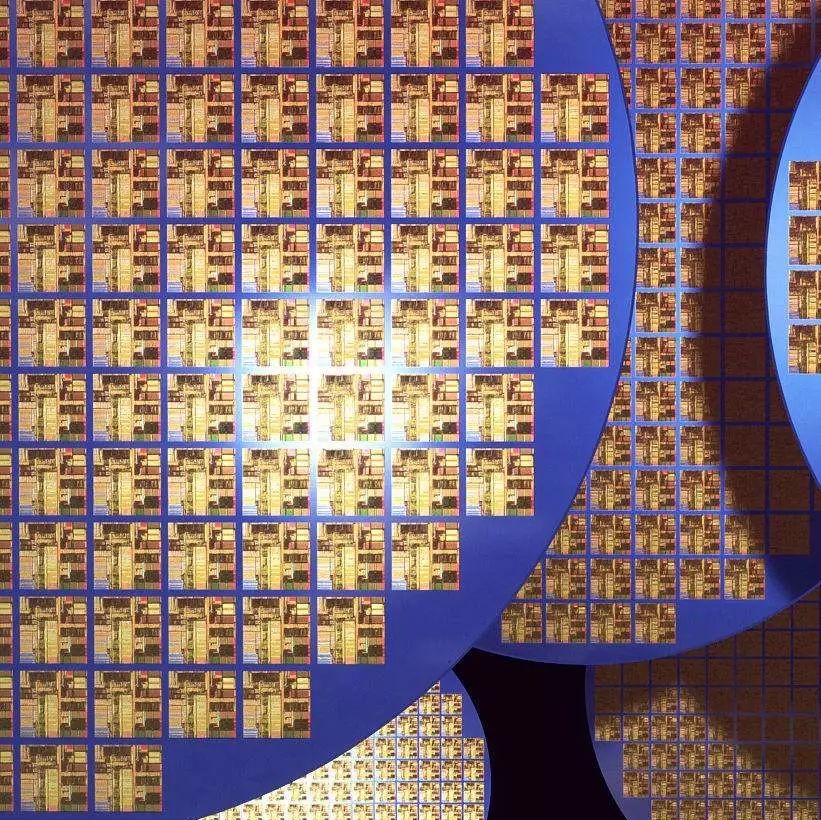

据anandtech报道,高性能计算 (HPC) 领域越来越明显的一个趋势是,每个芯片和每个机架单元的功耗不会因空气冷却的限制而停止。由于超级计算机和其他高性能系统已经达到——并且在某些情况下超过了这些限制——功率要求和功率密度不断扩大。根据台积电最近一年一度的技术研讨会的消息,随着台积电为更密集的芯片配置奠定基础,我们应该期待看到这种趋势继续下去。

手头的问题并不是一个新问题:晶体管功耗的缩小速度几乎没有晶体管尺寸那么快。由于芯片制造商不会放弃性能(并且无法为客户提供半年增长),因此在 HPC 空间中,每个晶体管的功率正在迅速增长。另一个问题是,chiplet正在为构建具有比传统标线限制更多硅的芯片铺平道路,这对性能和延迟有好处,但在冷却方面更成问题。

支持这种硅和功率增长的是 台积电 CoWoS 和 InFO等现代技术,它们允许芯片制造商构建集成的多芯片系统级封装 (SiP),其硅量是台积电的两倍。受到标线(reticle )限制。到 2024 年,台积电 CoWoS 封装技术的进步将使构建更大的多芯片 SiP 成为可能,台积电预计将超过四个标线大小的芯片缝合在一起,这将实现巨大的复杂性(每个 SiP 有可能超过 3000 亿个晶体管)台积电及其合作伙伴正在关注)和性能,但自然是以巨大的功耗和发热为代价的。

NVIDIA 的 H100 加速器模块等旗舰产品已经需要超过 700W 的功率才能实现峰值性能。因此,在单个产品上使用多个 GH100 大小的chiplet的前景令人大跌眼镜 - 以及功率预算。台积电预计,几年后将出现功耗约为 1000W 甚至更高的多芯片 SiP,从而带来冷却挑战。

在 700W 时,H100 已经需要液冷;英特尔的基于chiplet的 Ponte Vecchio 和 AMD 的 Instinct MI250X 的故事大致相同。但即使是传统的液体冷却也有其局限性。当芯片累计达到 1 kW 时,台积电设想数据中心将需要为这种极端的 AI 和 HPC 处理器使用浸入式液体冷却系统。反过来,浸入式液体冷却将需要重新构建数据中心本身,这将是设计上的重大变化,也是连续性方面的重大挑战。

撇开短期挑战不谈,一旦数据中心设置为浸入式液体冷却,它们将为更热的芯片做好准备。液浸式冷却在处理大型冷却负载方面具有很大潜力,这也是英特尔大力投资这项技术以使其更加主流化的原因之一。

除了浸没式液体冷却,还有另一种技术可以用来冷却超热芯片——片上水冷。去年,台积电透露它已经尝试过片上水冷,并表示甚至可以使用这种技术冷却 2.6 kW 的 SiP。但当然,片上水冷本身就是一项极其昂贵的技术,它将把那些极端的 AI 和 HPC 解决方案的成本推到前所未有的水平。

尽管如此,虽然未来不是一成不变的,但似乎它已经用硅铸造了。台积电的芯片制造客户有客户愿意为这些超高性能解决方案(想想超大规模云数据中心的运营商)支付高昂的费用,即使这需要高成本和技术复杂性。让事情回到我们开始的地方,这就是台积电首先开发 CoWoS 和 InFO 封装工艺的原因——因为有客户准备好并渴望通过chiplet技术打破标线限制。今天,我们已经在 Cerebras 的大型晶圆级引擎处理器等产品中看到了其中的一些,并且通过大型小芯片,台积电正准备让更广泛的客户群更容易获得更小的(但仍然是标线断裂)设计。

对性能、封装和冷却的这种极端要求不仅将半导体、服务器和冷却系统的生产商推向了极限,而且还需要对云数据中心进行修改。如果用于 AI 和 HPC 工作负载的大规模 SiP 确实变得普遍,那么未来几年云数据中心将完全不同。

★ 点击文末 【阅读原文】 ,可查看本文原文链接!

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第3084内容,欢迎关注。

推荐阅读

半导体行业观察

『 半导体第一垂直媒体 』

实时 专业 原创 深度

识别二维码 ,回复下方关键词,阅读更多

晶圆|集成电路|设备 |汽车芯片|存储|台积电|AI|封装

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复 搜索 ,还能轻松找到其他你感兴趣的文章!

-

- 半导体行业观察

-

- 摩尔芯闻