来源:内容由半导体行业观察(ID:icbank)

编译自nextplatform

,

谢谢。

本周是 Google I/O 2022,除此之外,我们希望对Google 在去年的 I/O 活动中暗示

的 TPUv4 矩阵数学引擎进行架构深入研究。

这家搜索引擎和广告巨头是这个星球上最大的人工智能创新者之一,因为它需要使用大量的数据,它确实也在大会上提供了更多关于 TPUv4 处理器和使用的更多信息。

谷歌还表示,它正在俄克拉荷马州梅斯县的数据中心安装 8 个 TPUv4 系统Pods,该数据中心正在接近 9 exaflops的总计算能力,供其谷歌云部门使用,这样研究人员和企业就可以访问相同的类型和谷歌必须自己进行内部人工智能开发和生产的计算能力。

自 2007 年以来,谷歌一直在塔尔萨东北部的梅斯县运营数据中心,自那时以来已投资 44 亿美元用于设施建设。它位于美国的地理中心——就在它的南边和西边——这使得它很有用,因为它对美国大部分地区的延迟相对较短。现在,根据定义,梅斯县拥有世界上最大的铁矿之一来推动人工智能工作量。(如果八个 TPUv4 pod 联网在一起并且可以同时工作,我们可能会毫不含糊地说“最大的”......谷歌肯定做到了,正如您将在下面的引用中看到的那样。)

在他的主题演讲中,谷歌及其母公司 Alphabet 的首席执行官 Sundar Pichai 顺便提到,TPUv4 pod 正在其云上进行预览。

“我们今天分享的所有进步都是可能的,因为我们的基础设施不断创新,”Pichai 谈到一些非常有趣的自然语言和沉浸式数据搜索引擎增强功能时说,它已经将这些功能融入到各种应用中。“最近,我们宣布计划在美国各地的数据中心和办事处投资 95 亿美元。我们最先进的数据中心之一位于俄克拉荷马州的梅斯县,我很高兴地宣布,我们将为我们所有的 Google Cloud 客户推出全球最大的公开机器学习中心。这个机器学习中心有 8 个 Cloud TPU v4 pod,它们是在为 Google 最大的神经模型提供支持的同一网络基础设施上定制构建的。总共提供近 9 exaflops 的计算能力,为我们的客户带来前所未有的运行复杂模型和工作负载的能力。我们希望这将推动从医药到物流再到可持续发展等各个领域的创新。”

Pichai 补充说,这个基于 TPUv4 Pods的人工智能中心已经有 90% 的电力来自可持续的无碳资源。(他没有说风能、太阳能或水电有多少。)

在我们了解 TPUv4 芯片和 Pod 的速度和馈送之前,可能值得指出的是,据我们所知,Google 已经在其面向内部的数据中心中拥有 TPUv5 Pod,而且它可能拥有更大的集合的 TPU 来驱动自己的模型并使用 AI 算法和例程增强自己的应用程序。那将是 Google 做事的老方法:在销售N-1代产品时谈论N代产品,并且已经转移到N+1代产品来处理其内部工作负载。

情况似乎并非如此。在Google Cloud 副总裁兼基础设施总经理 Sachin Gupta 和 Cloud TPU 产品经理 Max Sapozhnikov 撰写

的博客文章

中,去年构建 TPUv4 系统时,Google 向 Cohere 的研究人员提供了早期访问权限、LG AI Research、Meta AI 和 Salesforce Research,此外,他们还补充说,TPUv4 系统用于创建 Pathways 语言模型 (PaLM),该模型支持作为今天主题演讲核心的自然语言处理和语音识别创新。具体来说,PaLM 是在两个 TPUv4 pod 上开发和测试的,每个 pod 都有 4,096 个 TPUv4 矩阵数学引擎。

如果谷歌最闪亮的新模型是在 TPUv4 上开发的,那么它可能没有隐藏在某个数据中心的 TPUv5 舰队。虽然我们会添加,但如果 TPUv5 机器被隐藏在距离我们办公室西南 26.7 英里处的 Lenoir 数据中心,那就太好了。

让我们谈谈一些反馈和速度。最后,这里是一些将 TPUv4 与 TPUv3 进行比较的容量:

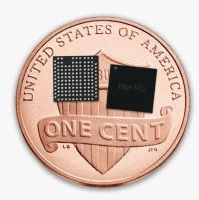

去年,当 Pichai 暗示 TPUv4 时,我们猜测谷歌正在为这一代 TPU 转向 7 纳米工艺,但考虑到非常低的功耗,它看起来可能是使用 5 纳米工艺蚀刻的。(我们假设谷歌试图保持功率包络不变,它显然想减少它。)我们还猜测它正在将核心数量增加一倍,从 TPUv3 上的两个核心移动到 TPUv4 上的四个核心,这谷歌没有确认或否认。

在内核翻倍的同时将性能翻倍将使 TPUv4 达到每芯片 246 teraflops,从 16 纳米到 7 纳米将允许在大致相同的功率包络和大约相同的时钟速度下翻倍。转向 5 纳米可以使芯片更小,运行速度更快,同时降低功耗——随着 5 纳米工艺的成熟,芯片更小,成品率可能更高。平均功耗下降了 22.7%,考虑到二换工艺节点从 TPUv3 跳转到 TPUv4,时钟速度提高了 11.8%。

该表和 Google 在此博客中所做的声明中有一些非常有趣的内容。

除了 TPUv4 的芯片制造过程带来的 2X 内核和轻微的时钟速度增加之外,有趣的是,谷歌将内存容量保持在 32 GB,并且没有转移到 Nvidia 与“Hopper”一起使用的 HBM3 内存GH100 GPU 加速器。Nvidia 痴迷于设备上的内存带宽,并且通过其 NVLink 和 NVSwitch 扩展,节点内的内存带宽以及现在跨节点的内存带宽,单个映像中最多有 256 个设备。

Google 并不担心专有 TPU 互连、设备内存带宽或设备内存容量上的内存原子(据我们所知)。TPUv4 具有与 TPUv3 相同的 32 GB 容量,它使用相同的 HBM2 内存,并且速度仅提高了 33%,低于 1.2 TB/秒。Google 感兴趣的是 TPU Pods互连的带宽,它正在转向 3D 环面设计,该设计将 64 个 TPUv4 芯片与“环绕连接”紧密耦合——这是与 TPUv3 Pods一起使用的 2D 环面互连无法实现的。环面互连尺寸的增加允许将更多 TPU 拉入更紧密的子网以进行集体操作。(这引出了一个问题,为什么不是 4D、5D 或 6D 环面呢?)

TPUv4 pod 的 TPU 芯片数量是之前的4 倍——高达4,096个 ,TPU 内核的数量则高达16,384 ,是之前的两倍;我们相信 Google 已将 MXU 矩阵数学单元的数量保持在每个内核两个,但这只是一种预感。

Google 可以保持 TPU 核心数量相同,并将 MXU 单元增加一倍,并获得相同的原始性能;不同之处在于需要在这些 MXU 上完成多少前端标量/矢量处理。无论如何,在 Google 的 DeepMind 部门创建的 16 位 BrainFloat (BF16) 浮点格式下,TPUv4 pod 提供 1.1 exaflops算力,而 BF16 仅提供 126 petaflops。原始计算量增加了 8.7 倍,与整个 pod 的 all-to-all 缩减带宽增加了 3.3 倍以及整个 pod 的 TPUv4 互连的对分带宽增加了 3.75 倍相平衡。

博客中的这句话引起了我们的兴趣:“每个 Cloud TPU v4 芯片的峰值 FLOP 比 Cloud TPU v3 多约 2.2 倍,每美元的峰值 FLOP 多约 1.4 倍。” 如果您根据该声明进行计算,这意味着使用 TPUv4 在 Google Cloud 上租用 TPU 的价格上涨了 60%,但它的工作量是原来的2.2 倍。这种定价和性能飞跃与 Google 期望从其为其数据中心购买的交换机 ASIC 中获得的那种价格/性能改进完全一致,这些交换机通常以 1.3 到 1.5 倍的成本提供 2 倍的带宽。

TPUv4 有点贵,但它有更好的网络来运行更大的模型,这也有成本。

TPUv4 pod 可以在 Google Cloud 上的 VM 中运行,大小从低至四个芯片到“数千个芯片”不等,我们认为这意味着包括整个 pod。

★ 点击文末

【阅读原文】

,可查看本文原文链接!

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第3038内容,欢迎关注。

『

半导体第一垂直媒体

』

实时 专业 原创 深度

识别二维码

,回复下方关键词,阅读更多

晶圆|集成电路|设备

|汽车芯片|存储|台积电|AI|封装

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复

搜索

,还能轻松找到其他你感兴趣的文章!