来源:内容由半导体行业观察(ID:icbank)编译自「

tomshardware

」,谢谢。

Nvidia于本周早些时候宣布了其首款用于AI以及HPC服务器的基于Arm的Grace处理器,尽管许多市场观察家都预料到了这一举动,但正式的首次亮相对AMD以及Intel的股价都造成了负面影响。

毫无疑问,英伟达是一个强大的竞争对手,但英特尔认为,它并没有真正威胁到其数据中心业务。

英特尔新任首席执行官帕特·盖辛格(Pat Gelsinger)在接受《财富》采访时说:“我们上周宣布了我们的Ice Lake [服务器处理器],并获得了非常积极的回应 。” “我们的Ice Lake 在AI功能方面进行了非凡的扩展。(英伟达)正在回应我们。不是我们对此做出回应。显然,这种AI增强型CPU的想法是英特尔在其中发挥了巨大的领导作用的领域。”他进一步指出,英特尔还拥有我们的Habana产品线(英特尔在2019年收购了一家专业的AI芯片制造商),毫无疑问地奠定了一条非常进取的道路,而我们与亚马逊的云合作伙伴关系就是一个很好的例证。

“显然,我想说CPU的想法就是Intel的起源。我们现在正在将AI融入其中,我们希望这将是我们进攻的一个领域,而不是未来的防守。”Pat Gelsinger说。

Nvidia的适用于AI和HPC机器的Grace处理器有望在AI和选择HPC工作负载方面比当今的x86处理器快10倍以上,但它要到2023年初发布。像这样的性能期望看起来总是非常强大,但是其中之一必须记住,AMD和Intel的竞争并没有停滞不前。

在早前的介绍中我们说到,英特尔最新的Xeon处理器以DL Boost的名义集成了AI加速技术,该技术目前包括AVX512_VNNI(Cascade Lake和冰湖)和AVX512_BF16(尽显Cooper Lake )等指令集扩展。事实证明,两者都具有相当的竞争力(至少根据Intel进行的测试 ),并且在处理优化算法时,它们可使Intel的CPU性能比Nvidia的GPU 高15倍。

此外,由于英特尔的Xeon CPU的使用如此广泛,因此它们被广泛用于推理工作负载,而ISV为这些处理器优化了其引擎。简而言之,现代英特尔的至强可扩展产品已经具有AI增强功能,其后续产品自然会扩展AI功能。

总的来说,Arm,AMD,Intel,Nvidia和许多其他公司正在努力提高其处理器(CPU,GPU,IPU,VPU等)在AI和/或HPC工作负载中的性能,以应对人工智能的需求。超级计算正在迅速发展。因此,与过去的30年相比,未来几年AI和HPC方向将取得更大进步。

需要注意的是,Nvidia当前显示其Grace CPU位于GPU旁边,而不是单独显示。因此,尽管Grace处理器本身可能具有众多AI增强器,但Nvidia将与针对计算进行了优化的数据中心GPU一起出售它们,从而为AI和HPC工作负载提供了具有令人印象深刻的功能的平台。

同时,英特尔将在2022年推出一个类似的平台。英特尔的第四代至强可扩展“Sapphire Rapids'” 处理器(具有多达56个内核)以及针对各种工作负载的众多增强功能,将伴随着该公司1000亿晶体管的 Ponte Vecchio 计算GPU明年出现在 Aurora超级计算机中。英特尔的GPU似乎具有大约1 FP16 PFLOPS性能或1,000 TFLOPS FP16性能,这是Nvidia A100的312 FP16 TFLOPS的三倍。

★ 点击文末

【阅读原文】

,可查看本文原文链接!

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

今天是《半导体行业观察》为您分享的第2646内容,欢迎关注。

『

半导体第一垂直媒体

』

实时 专业 原创 深度

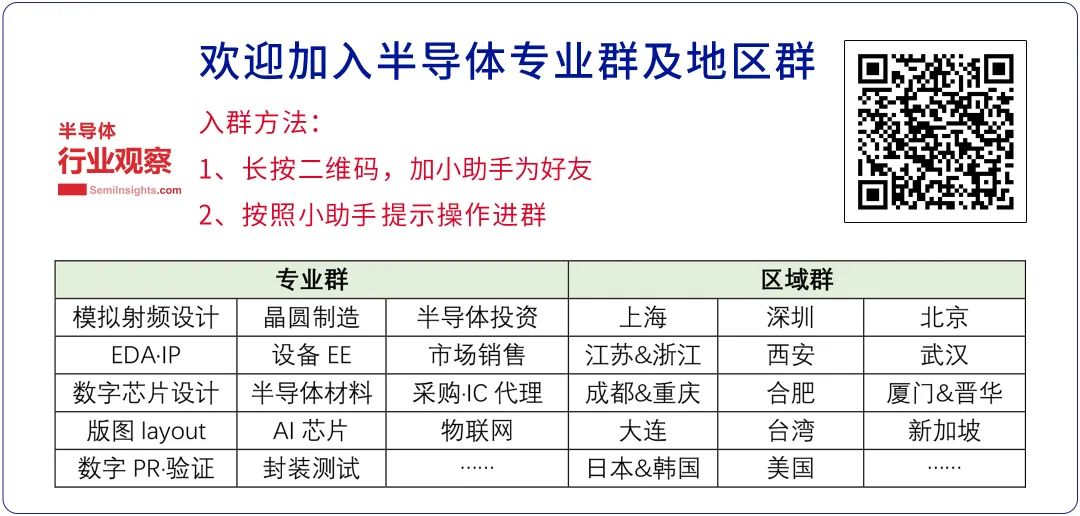

识别二维码

,回复下方关键词,阅读更多

晶圆|集成电路|设备|封测

|射频|存储|美国|台积电

回复

投稿

,看《如何成为“半导体行业观察”的一员 》

回复

搜索

,还能轻松找到其他你感兴趣的文章!