最新MLPerf测试:Arm CPU性能不输X86系统

2021-09-23

18:24:50

来源: 互联网

点击

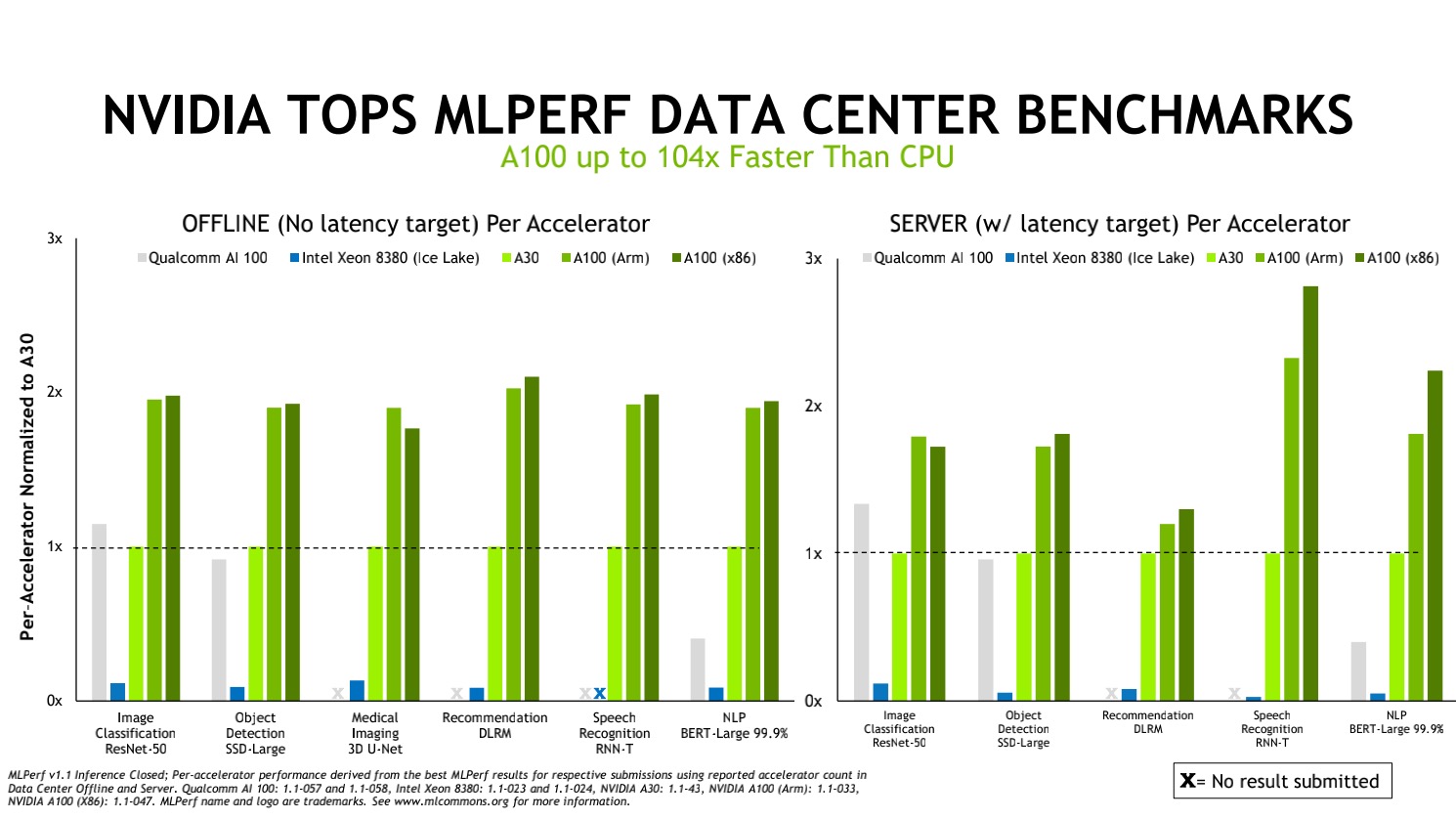

根据近日发布的基准测试结果,NVIDIA在使用x86及Arm CPU进行AI推理时取得了最佳成绩。英伟达表示,它已经证明,当与用于 AI 应用程序(特别是机器学习推理)的 GPU 搭配使用时,基于 Arm 的 CPU 可以提供与基于 x86 的 CPU 几乎相同的性能水平。这场测试是第一次在Arm系统上进行数据中心类别的测试,此举将使得用户在部署AI这一目前最具变革性的技术时有了更多的选择。

Arm CPU性能不输X86系统

凭借在能效性能上的不断增长和不断扩展的软件生态系统,Arm架构正在向全球各地的数据中心进军。最新基准测试表明,在英伟达GPU加速的平台驱动下,在AI推理工作中,使用Ampere Altra CPU的Arm服务器与具有类似配置的X86服务器提供的性能几乎相同。事实上,在其中的一项测试中,Arm服务器的性能甚至超过了类似配置的x86系统。

当涉及到需要在线连接的测试时,基于 Arm 的系统在 ResNet-50 图像分类模型上有轻微的性能优势,而基于 X86 的系统在 SSD-Large object detection 和 DLRM 推荐模型上有类似的优势。但是,对于 RNN-T 和 BERT-Large 模型,基于 x86 的系统具有更大的优势。

根据 Salvator 的说法,基于 Arm 的系统和基于 x86 的系统之间的性能结果基本相似,这是“一个重要的里程碑”。

NVIDIA一直以来支持所有类型的CPU架构,十分高兴地看到Arm在同行评审的行业基准测试中能够证明其AI性能。

“在我们的客户中,需要有一些大的、明确的卖点,说明他们为什么需要改用新架构,”他说。Eshelmen 表示,Arm 最终可能会推出架构改进,这将使其在人工智能方面优于英特尔和 AMD,但他认为性能提升更有可能来自英伟达计划在 CPU 和 GPU 之间进行的互连工作这家芯片制造商即将推出的基于 Arm 的数据中心 CPU。

Arm高性能计算和工具高级总监David Lecomber表示:“作为MLCommons的创始成员,Arm致力于通过创建标准和基准来更好地应对挑战并激发加速计算行业的创新。”“最新推理结果表明,Arm CPU和NVIDIA GPU驱动的Arm系统已能够应对数据中心中的各种AI工作负载。”

这是NVIDIA连续第三次在MLCommons推理测试中创造性能和能效纪录。MLCommons是一家成立于2018年5月的行业基准测试组织。

英伟达在AI中取得成功的关键因素

NVIDIA能够在所有AI用例中取得成功的一个关键因素是其完整的软件栈。在推理方面,这包括针对各种用例的预训练AI模型。NVIDIA TAO Toolkit运用迁移学习为特定应用定制这些模型。

NVIDIA TensorRT软件对AI模型进行了优化,使其能够最有效地运用内存并且实现更快的运行速度。NVIDIA经常使用该软件进行MLPerf测试,该软件可用于X86和Arm的系统。

在这些基准测试中,NVIDIA还采用了NVIDIA Triton 推理服务器软件和多实例GPU(MIG)功能。它们为所有开发者提供了通常需要专家级程序员才能实现的性能。随着该软件栈的不断改进,与四个月前的MLPerf推理基准测试相比,NVIDIA提升了高达20%的性能和15%的能效。

NVIDIA在最新测试中所使用的所有软件都可以从MLPerf资源库中获得,因此任何人都可以重现NVIDIA的基准测试结果。NVIDIA会陆续将这些代码添加到NVIDIA的深度学习框架和容器中,用户可在NVIDIA的GPU应用软件中心NGC上获得这些框架和容器。

其作为全栈式AI平台的一部分,支持所有主要的处理器架构,已在最新行业基准测试中得到了验证,并可通过多家合作伙伴获取,助力客户应对当今的实际AI工作任务。

MLPerf测试让用户放心使用

深度学习包括训练和推理两方面。推理(Inference)指计算机通过运行AI软件来识别对象或进行预测。在这个过程中,计算机使用深度学习模型来过滤数据,进而发现人类所无法捕捉的结果。现在有数以亿计的运算GPU在训练更大的模型,需要加速产品的上市时间。每天有10亿的图像,声音,视频需要GPU推理快速响应,最大化数据中心吞吐量。

在最新一轮测试中,由NVIDIA AI平台驱动的系统在所有七项推理性能测试中都名列前茅,这些系统来自NVIDIA和其九家生态系统合作伙伴,包括阿里巴巴、戴尔科技、富士通、技嘉、慧与、浪潮、联想、宁畅和超微。NVIDIA是唯一一家在本轮和迄今为止每一轮测试中取得所有MLPerf测试结果的公司。

为什么对于AI来说,要一直强调性能。因为随着AI用例从数据中心扩展到边缘和其他领域,AI模型和数据集将不断增加。用户需要既可靠又能灵活部署的性能。MLPerf推理基准测试基于当今最常用的AI工作负载和场景,涵盖计算机视觉、医学影像、自然语言处理、推荐系统、强化学习等。因此,无论用户部署何种AI应用,都可以通过NVIDIA创造自己的纪录。

MLPerf让用户有信心做出明智的购买决定。该组织得到了几十家行业领导者的支持,包括阿里巴巴、Arm、百度、谷歌、英特尔和NVIDIA,因此这些测试是透明的和客观的。

NVIDIA AI技术得到了广大和日益扩展的生态系统的支持。在最新基准测试中,七家OEM厂商共提交了22个GPU加速的平台。这些服务器中的大多数型号都是NVIDIA认证系统,经验证可以运行多种加速工作负载,而且其中很多型号都支持上个月正式发布的NVIDIA AI Enterprise软件。参与本轮测试的合作伙伴包括戴尔科技、富士通、慧与、浪潮、联想、宁畅、超微以及云服务提供商阿里巴巴。

责任编辑:sophie

相关文章

-

- 半导体行业观察

-

- 摩尔芯闻

最新新闻

热门文章 本日 七天 本月

- 1 NVIDIA重磅出击:三台计算机助力人形机器人飞跃

- 2 TSN芯片,上车!

- 3 奕行智能(EVAS Intelligence)完成数亿元A轮融资,加速推出RISC-V计算芯片产品,共同助力新时代到来

- 4 汽车芯片需求激增,南芯科技加速推进“第二增长曲线”