AI加速器竞争白热化 NVIDIA捍卫江山有筹码

来源:内容来自digitimes ,谢谢。

随着人工智能(AI)服务器GPU加速器需求转热,越来越多大厂投入市场,不禁令人好奇,面对新对手接连进逼,一直处于领先地位的NVIDIA如何捍卫江山,未来是否有筹码还击。

当市场需求攀升,少数供应商得到丰厚的获利时,更多的厂商即会相继投入抢食大饼,这是基本的经济运作。在AI加速器市场亦然,NVIDIA早期跨入此领域,拜企业和云端服务业者AI相关投资与日具增之赐,NVIDIA的Tesla GPU需求畅旺,公司业绩也大进补。

以2017年上半为例,NVIDIA首季数据中心产品销售激增逾2倍,第2季续增186%。NVIDIA在AI领域耀眼的表现引起其他科技大厂的注意,过去1年来包括英特尔(Intel)、超微(AMD)、富士通(Fujitsu)和Alphabet相继推出AI服务器加速器,或宣布准备进军市场。

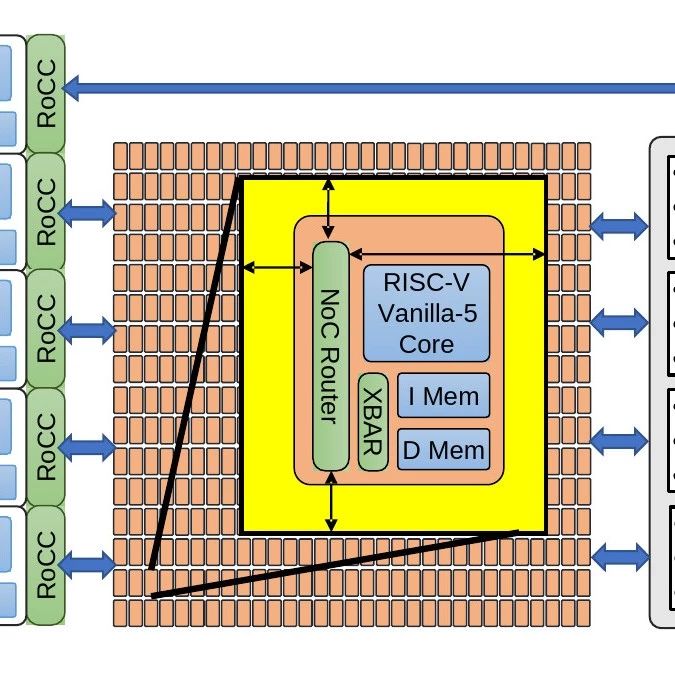

随着市场竞争逐渐白热化,NVIDIA该如何维持竞争优势?这可以从比较NVIDIA的GPU和对手产品找到答案。服务器CPU与PC和移动CPU一样,仅能容纳少量相对强而有力的CPU核心,例如最强而有力的英特尔Xeon Scalable服务器CPU有28核。反观GPU可以有上千个小核心并行运作。也因此,对于不断地进行演算和推论的AI深度学习训练而言,GPU比CPU更适合。

推论演算法不一定要求巨大的处理能力,GPU就可以应付这些任务,有鉴于此,NVIDIA试着让GPU在此获得更多的采用。不过,许多服务器端的推论工作仍然以英特尔的Xeon CPU为主。苹果(Apple)因隐私权的关系,偏好直接在iOS装置以AI演算法处理用户数据。

然而,训练深度学习模型来创造演算法解读数据,例如自动驾驶系统翻译简讯或侦测交通号志等都需要密集的运算,训练过程中,数千甚至数百万个人工神经元化分成许多“层”(layer,如输入层、隐藏层、输出层等)来负责不同的任务,以及和其他层的神经元沟通,以便判断数据分析后的结果是否无误,例如输入的影像是否为停车标志(stop sign)等。

比起不到30核心的CPU,AI研究人员利用多个拥有数千个核心的Tesla GPU来分担人工神经元的工作,训练深度学习模型将加快许多。深度学习演算是一种复杂的数学,而这正是NVIDIA的Tesla GPU擅长的领域,它还可以提供一个具有众多存储器频宽的模型,以及高速连结芯片来进行沟通。

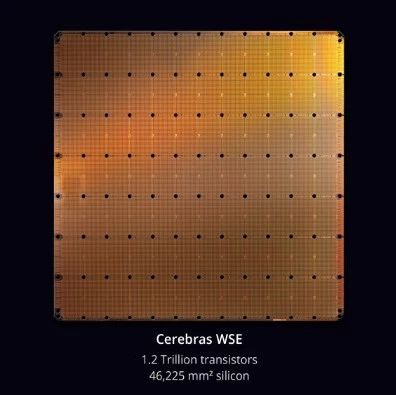

但这并不意味着GPU是唯一适合训练深度学习模型的处理器,理论上芯片制造厂也可以开发一个配备数千个核心,专为处理深度学习演算而设计的特殊应用积体电路(ASIC),让它们能与存储器或其他ASIC快速沟通。

英特尔似乎有这样的想法,2016年收购Nervana Systems取得必要的技术和人才后,着手打造深度学习ASIC“Lake Crest”。英特尔号称Lake Crest的并行处理能力是前所未见的水准,原始运算能力比当前最先进的GPU(显然指的是NVIDIA)还强。此外,Lake Crest还可支援每秒1兆位元(TB)的存储器频宽,连结速度比标准PCI Express快20倍。

Lake Crest将于年底问世,英特尔同时也准备推出Knights Crest,此为整合Nervana技术的Xeon Phi协同处理器其中的一个版本。Xeon Phi芯片应用于较不复杂的AI专案,以及高速运算(high-performance computing;HPC)工作负载上。

Google最近发表第二代Tensor Processing Unit(TPU),第一代TPU仅有推论能力,新的TPU则可训练深度学习模型。Google宣称TPU模组在特定的深度学习运作中,可以达到每秒180兆次的浮点运算(teraflop),比NVIDIA最近发表的Tesla V100旗舰服务器GPU的120 teraflop还快。不过,TPU仅能与Google的TensorFlow软件架构并用,而且Google不打算销售TPU,只用于公司内部AI开发,以及让云端客户使用。

其他大厂如AMD最近推出Radeon Instinct服务器GPU,其中最强的M125是不错的产品,但以原始效能来看仍落后V100,特别是64-bit运算时,而且存储器频宽也比较少,目前显然不至于对Tesla GPU构成威胁。此外,富士通最近也宣布要在2018年会计年度发布一个ASIC深度学习处理器。

不过,尽管新对手来势汹汹,NVIDIA拥有强有力的武器来予以迎击。其中之一是庞大的GPU研发支出,NVIDIA主要用于打造新的GPU架构,特别是深度学习的GPU。例如Tesla V100采用新的Volta GPU架构,同时使用了5,120个传统的CUDA GPU核心和640个tensor核心作为深度学习训练之用。

但就长期而言,NVIDIA最大的竞争优势或许起步比别人早,围绕着Tesla GPU的AI生态系统已经成形。现在开发者逐渐习惯使用NVIDIA的CUDA GPU应用程式介面(API),以及深度软件开发套件的各种工具,包括cuDNN软件图书馆等。

NVIDIA的生态系统也吸引其他科技巨擘的参与,4月NVIDIA和Facebook宣布共同合作,为Tesla GPU提升Facebook的Caffe2 AI软件架构。不久之后,微软(Micorsoft)也宣布,该公司新版SQL服务器数据库将可与Tesla GPU一起运作处理深度学习的工作。

今天是《半导体行业观察》为您分享的第1359期内容,欢迎关注。

R

eading

推荐阅读(点击文章标题,直接阅读)

关注微信公众号 半导体行业观察,后台回复关键词获取更多内容

回复 比亚迪 ,看《比亚迪的芯片布局,王传福的野心》

回复 长电科技 ,看《从江阴小厂到世界前三,长电科技一路狂奔》

回复 英特尔 ,看《四面楚歌,Intel还能重回巅峰吗?》

回复 全面屏 ,看《全面屏手机给供应链带来的挑战》

回复 芯片市场 ,看《又一个被中国厂商做死的芯片市场!》

回复 展会,看《2017最新半导体展会会议日历》

回复 投稿 ,看《如何成为“半导体行业观察”的一员 》

回复 搜索 ,还能轻松找到其他你感兴趣的文章!

摩尔邀请您加入精英微信群

你好,感谢长期对半导体行业观察的关注和支持!为了方便各位精英专家交流,我们组建了一些专业、微信交流群,欢迎你加入,我们还会邀请在摩尔直播App做过技术和行业分享的100+技术大牛入群和大家交流。加群方法: 长按二维码,加群主为好友,填写加群需求信息,拉你入群。(微信限制每天好友添加数量只有300人,请耐心等待)

地域群:

上海、深圳、北京、江苏.浙江、西安、武汉、成都.重庆、合肥、厦门.晋华、大连、台湾、新加坡、日本.韩国、美国、欧洲、摩尔直播学习群。

专业群:

模拟射频设计、EDA.IP、数字芯片设计、模拟混合信号设计、版图Layout、数字PR.验证、晶圆制造Fab、设备EE、半导体材料、半导体设备、封装测试、半导体投资、市场销售、AE.FAE、嵌入式开发、实习交流、采购.IC代理、AI芯片

专业微信群规则:

1. 专业、高效交流,建议进群请修改群昵称,格式:公司或学校+职位或专业+中文或英文,请服从群主管理,如果多次违规会被请出交流群;

2. 原则上每人加不超过3个群,精彩讨论内容,群主会负责在不同群同步,既然加了群,请大家尽量置顶群,积极参与群讨论;

3. 群里聊天讨论仅限半导体专业内容,杜绝专业无关内容,特别是养生、拉票、微商等内容,严格禁止,为自己公司打广告以不引起群友反感为限;

-

- 半导体行业观察

-

- 摩尔芯闻

最新新闻

热门文章 本日 七天 本月

- 1 TCB,尚能饭否?

- 2 ISSCC2019 PLLpaper论文鉴赏(一)——SubsamplingPLL

- 3 2025开年前瞻:技术研发领域的关注要点与未来走向

- 4 一文看懂IGBT的七代发展史